Rust 从零到生产 简体中文版

本书为 《Zero to Production in Rust》的非官方翻译

欢迎贡献: cubewhy/zero2prod-zhcn

边学边翻译的, 可能有点慢/不准确...

只是自用翻译, 很多地方有个人成分... 如果有出错的地方请开issue告诉我哦

有的注解是我自己写的, 原作的话那些部分是不存在的

使用谷歌翻译+人工校对翻译

翻译版本的代码使用 Rust 2024, 过时代码已迁移到可用写法

序言

前言

当你读到这些文字时,Rust 已经实现了它最大的目标:向程序员们提供机会,让他们用另一种语言编写他们的生产系统。读完本书后,你仍然可以选择是否采用这种方式,但你已经具备了考虑这个机会所需的一切。我参与了两种截然不同的语言:Ruby 和 Rust 的成长历程——不仅参与编程,还举办活动、参与项目管理,并围绕它们开展业务。通过这些,我有幸与许多语言的创造者保持联系,并将其中一些人视为朋友。Rust 是我一生中唯一一次见证并帮助一门语言从实验阶段发展到被业界广泛接受的机会。

我要告诉你一个我一路走来学到的秘密:编程语言的采用并非因为功能清单。这是一个复杂的相互作用,它需要优秀的技术、谈论它的能力,以及找到足够多愿意长期投资的人。当我写下这些文字时,已有超过 5000 人利用业余时间为 Rust 项目做出了贡献,而且通常是免费的——因为他们相信这份赌注。

但你不必为编译器做出贡献,也不必被记录在 git log 中才能为 Rust 做出贡献。

Luca 的书就是这样一份贡献:它为新人提供了一个了解 Rust 的视角,并推广了众多优秀人士的优秀工作。

Rust 从未打算成为一个研究平台——它始终是一门编程语言,

用于解决大型代码库中实际存在的、切实可行的问题。毫不奇怪,它出自一个维护着庞大而复杂代码库的组织——Mozilla,Firefox 的创建者。我加入 Rust 时, 只是怀揣着雄心壮志——但这个雄心壮志是将研究成果产业化,让未来的软件变得更好。凭借其丰富的理论概念、线性类型、基于区域的内存管理,这门编程语言始终面向所有人。

这反映在其术语中:Rust 使用像“所有权”和“借用”这样通俗易懂的名称来指代我刚才提到的概念。Rust 是一门彻头彻尾的工业语言。

这也反映在其支持者身上:我认识 Luca 多年,他是 Rust 社区的成员,对 Rust 了如指掌。但他更深层次的兴趣在于通过满足人们的需求,让他们相信 Rust 值得一试。本书的标题和结构体现了 Rust 的核心价值之一: 在编写可靠且有效的生产软件中发现它的价值。

Rust 的优势在于,它倾注了人们的精力和知识,从而高效地编写出稳定的软件。这种体验最好通过指南来获得,而 Luca 就是你能找到的关于 Rust 的最佳指南之一。

Rust 并不能解决你所有的问题,但它努力消除各种错误。有一种观点认为,语言中的安全特性是因为程序员的无能。我不认同这种观点。 Emily Dunham 在 2017 年 RustConf 主题演讲中完美诠释了这一点:“安全代码让你能够更好地承担风险”。Rust 社区的魅力很大程度上在于其对用户的积极看法:无论你是新手还是经验丰富的开发者,我们都信任你的经验和决策。在这本书中,Luca 提供了许多即使在 Rust 之外也能应用的新知识,并在日常软件实践中进行了详尽的解释。祝你阅读、学习和思考愉快。

Florian Gilcher,

Ferrous Systems 管理总监兼

Rust 基金会联合创始人

本书讲述了什么

后端开发领域广阔无垠。

你所处的环境对解决当前问题的最佳工具和实践有着巨大的影响。

例如,基于主干的开发方式非常适合编写在云环境中持续部署的软件。 同样的方法可能不太适合销售由客户托管和运行的软件的团队的业务模式和面临的挑战——他们更有可能从 Gitflow 方法中受益。 如果你是独自工作,可以直接推送到主干。 在软件开发领域,很少有绝对的事物,我认为在评估任何技术或方法的优缺点时,阐明你的观点是有益的。

“从零到生产”将重点关注由四到五名经验和熟练程度各异的工程师组成的团队编写云原生应用程序所面临的挑战。

云原生应用程序

定义 云原生应用 本身就足以写一本新书了[1]。与其规定云原生应用应该是什么样子,不如明确规定它们应该做什么。 借用 Cornelia Davis 的话来说,我们期望云原生应用:

- 在易发生故障的环境中运行时实现高可用性

- 在发布新版本的时候实现零停机

- 处理动态工作负载(workload)

这些要求对我们软件架构的可行解决方案空间有着深远的影响。

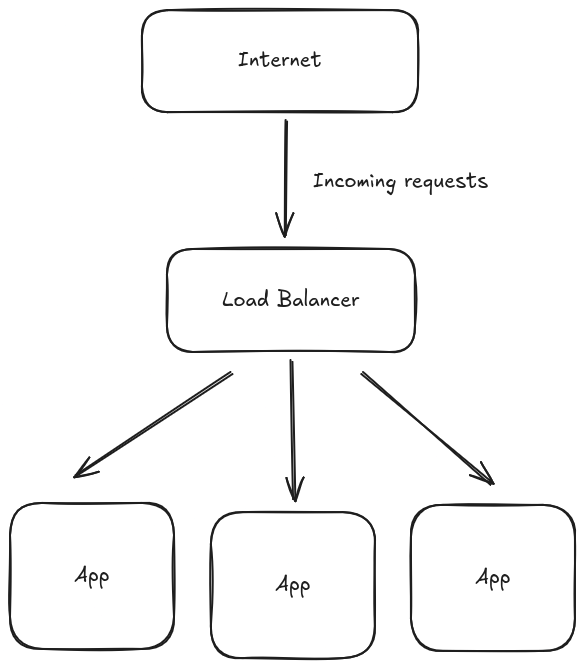

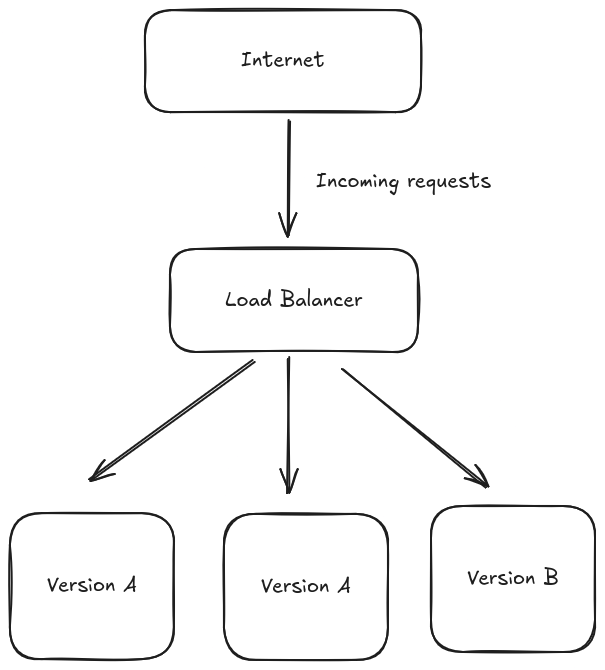

高可用性意味着,即使我们的一台或多台机器突然出现故障(云环境中的常见情况[2]),我们的应用程序也应该能够在不停机的情况下处理请求。

这迫使我们的应用程序必须分布式运行——应该在多台机器上运行多个实例。

如果我们想要处理动态工作负载,情况也是如此——我们应该能够衡量系统是否负载过重,并通过启动新的应用程序实例来投入更多计算资源来解决问题。这还要求我们的基础设施具有弹性,以避免过度配置及其相关成本。

运行复制应用程序会影响我们的数据持久化方法——我们将避免使用本地文件系统作为主存储解决方案,而是依靠数据库来满足我们的持久化需求。

因此, 《从零到生产》将广泛涵盖那些看似与纯后端应用程序开发无关的主题。但云原生软件的核心在于彩虹 (Rainbow [3]) 和 DevOps,我们将花费大量时间讨论传统上与操作系统技术相关的主题。

我们将介绍如何对 Rust 应用程序进行检测,以收集日志、跟踪和指标,以便能够观察我们的系统。

我们将介绍如何通过迁移设置和改进数据库架构。

我们将涵盖使用 Rust 解决云原生 API 第一天和第二天问题所需的所有材料。

- [1]: 就像 Cornelia Davis 的优秀云原生模式一样!

- [2]: 例如,许多公司在 AWS Spot 实例上运行软件,以降低基础设施成本。Spot 实例的价格是通过持续竞价确定的,可能比按需实例的全价便宜得多(最高可便宜 90%!)。但有一个问题:AWS 可以随时停用您的 Spot 实例。您的软件必须具备容错能力才能利用这一机会。

- [3]: 源书并没有这个注解, 关于什么是彩虹部署可以参考这个

和团队一起工作

这三个需求的影响超越了我们系统的技术特性:它影响着我们构建软件的方式。

为了能够快速向用户发布应用程序的新版本,我们需要确保我们的应用程序能够正常运行。

如果您正在独立开发一个项目,您可以依赖您对整个系统的透彻理解:您亲子编写了它,它可能很小,但是你随时可以回想起它的细节。[3] 如果您在团队中开发一个商业项目,您经常会遇到一些代码,这些代码既不是您编写的,也不是您审核的。原作者可能已经不在了。

如果您依赖于对代码功能的全面理解来防止代码崩溃,那么每次要引入更改时,您最终都会被恐惧所麻痹。(译者注: 俗称不敢动代码)

您需要写自动化测试。

在每次提交时自动运行。在每个分支上运行。保持 main 分支健康。

您需要利用类型系统使不良状态难以或无法表示。

您希望使用您掌握的所有工具,赋能团队中的每一位成员,让他们能够开发该软件。

即使他们可能不如您经验丰富,或者对代码库或您正在使用的技术不那么熟悉,他们也能全力投入开发过程。

因此,“从零到生产”项目从一开始就将重点放在测试驱动开发和持续集成上——我们甚至在启动和运行 Web 服务器之前就会设置 CI 流水线!

我们将介绍 API 的黑盒(black-box)测试和 HTTP mocking 等技术——这些技术在 Rust 社区中并不流行,文档也并不完善,但却非常强大。

我们还将借鉴领域驱动设计领域 (Domain Driven Design)的术语和技术,并将它们与类型驱动设计 (type-driven design)相结合,以确保系统的正确性。

我们的主要关注点是企业软件:写足以对领域进行建模的代码,并且支持长期演化。 (注: 就是说为未来考虑, 追求可维护性)

因此,我们会偏向于那些枯燥无味且正确的解决方案,即使它们会带来性能开销,而这些开销可以通过更谨慎、更精妙的方法进行优化。 先让它运行起来,然后再进行优化(如果需要)。

本书适合谁阅读

Rust 生态系统一直致力于通过面向初学者和新手的精彩资料打破采用障碍,从文档到编译器诊断的持续完善,我们付出了不懈的努力。 服务尽可能多的受众是有价值的。

同时,试图总是面向所有人讲解可能会产生有害的副作用:一些资料 可能与中级和高级用户相关,但对于初学者来说却太过繁琐和仓促, 最终会被忽视。

当我开始尝试使用 async/await 时,我亲身经历了这个问题。

我所需的高效知识与我通过阅读《Rust 之书》或在 Rust 数值生态系统中工作所积累的知识之间存在巨大差距。我想得到一个直截了当的问题的答案:

- Rust 能成为一种高效的 API 开发语言吗?

答案是肯定的。

但弄清楚如何操作可能需要一些时间。 这就是我写这本书的原因。 我写这本书是为了那些读过《The Rust Book》并正在尝试移植一些简单系统的经验丰富的后端开发人员。

我写这本书是为了我团队的新工程师,帮助他们理解未来几周和几个月将要贡献的代码库。

我写这本书是为了一个利基市场,我认为目前 Rust 生态系统中的文章和资源无法满足他们的需求。

一年前,我为自己写了这本书。

分享在学习过程中获得的知识:如果你在 2022 年使用 Rust 进行后端开发,你的工具箱是什么样的?有哪些设计模式?有哪些陷阱?

如果你不符合这个描述,但正在努力实现它,我会尽力帮助你:虽然我们不会直接涵盖很多内容(例如大多数 Rust 语言特性),但我会尽量在需要的地方提供参考资料和链接,帮助你在学习过程中掌握/理解这些概念。

让我们开始吧

入门

安装Rust工具链

在您的系统上安装 Rust 的方法有很多种,但我们将重点介绍推荐的途径:通过 rustup。

有关如何安装 rustup 的说明,请访问 rustup.rs

rustup 不仅仅是一个 Rust 安装程序——它的是一个工具链管理工具

工具链是编译目标和发布渠道的组合。

编译目标

Rust 编译器的主要目的是将 Rust 代码转换为机器码——一组 CPU 和操作系统能够理解和执行的指令。

因此,您需要为每个编译目标(即您想要生成可运行可执行文件的每个平台(例如 64 位 Linux 或 64 位 OSX))配备不同的 Rust 编译器后端。

Rust 项目致力于支持各种编译目标,并提供不同级别的保证。目标分为不同等级,从“保证可用”的 Tier 1 到“尽力而为”的 Tier 3。

您可以在此处找到详尽的最新列表。

发布频道

Rust 编译器本身是一个动态的软件:它随着数百名志愿者的日常贡献而不断发展和改进。

Rust 项目追求稳定,而非停滞不前。以下是 Rust 文档 中的一段话:

您无需担心升级到新版 Rust 的稳定版本。每次升级都应轻松无痛,同时还能带来新功能、更少的 Bug 和更快的编译时间。

因此,对于应用程序开发,您通常应该依赖编译器的最新发布版本来运行、构建和测试您的软件——即所谓的稳定版本。

编译器每六周就会在稳定版本上发布一个新版本 ──本文撰写时的最新版本是 v1.43.1。

另外两个发布频道是

- beta - 下一版本的候选版本

- nightly - 每个晚上自动从 rust-lang/rust 自动构建, 这也是nightly名字的由来

使用 Beta 编译器测试软件是支持 Rust 项目的众多方法之一 —— 它有助于在发布日期之前发现错误。

Nightly 编译器则有不同的用途:它让早期采用者在未完成的功能7发布之前(甚至在稳定之前!)能够使用它们。

如果您计划在 Nightly 编译器上运行生产软件,我建议您三思:它被称为不稳定是有原因的。

我们需要什么工具链

安装 rustup 将为您提供最新的稳定编译器,并以您的主机平台作为目标平台。stable 是本书中用于构建、测试和运行代码的发布渠道。

您可以使用 rustup update 更新您的工具链,而 rustup toolchain list 则会为您提供系统上已安装内容的概览。

我们不需要(或执行)任何交叉编译——我们的生产工作负载将在容器中运行,因此我们不需要从开发机器交叉编译到生产环境中使用的目标平台

初始化我们的项目

通过 rustup 安装的工具链会将各种组件捆绑在一起。 其中之一就是 Rust 编译器 rustc。您可以使用以下命令进行检查:

rustc --version

您无需花费大量时间直接使用 Rustc——您构建和测试 Rust 应用程序的主要界面将是 Rust 的构建工具 Cargo。

您可以使用以下命令再次检查一切是否正常运行

cargo --version

我们接下来用 cargo 创建项目的骨架, 在整本书里, 我们都要在这个项目上工作

cargo new zero2prod

项目文件夹 zero2prod 的结构看起来应该是这样的

zero2prod/

Cargo.toml

.gitignore

.git

src/

main.rs

该项目本身就是一个 Git 仓库,开箱即用。 (cargo 会自动创建git仓库) 如果您计划将项目托管在 GitHub 上,只需创建一个新的空仓库并运行

cd zero2prod

git add .

git commit -am "Project skeleton"

git remote add origin git@github.com:YourGitHubNickName/zero2prod.git

git push -u origin main

鉴于 GitHub 的受欢迎程度以及其最近发布的用于 CI 流水线的 GitHub Actions 功能,我们将以GitHub 为参考,但您可以自由选择任何其他 git 托管解决方案 (或根本不选择任何解决方案)

选择一个集成开发环境 (IDE)

项目框架已准备就绪,现在是时候启动你最喜欢的编辑器,开始摆弄它了。

每个人的偏好各不相同,但我认为,你至少应该拥有一个支持语法高亮、代码导航和代码补全的设置,尤其是在你刚开始学习一门新的编程语言时。

语法高亮可以立即反馈明显的语法错误,而代码导航和代码补全则支持“探索性”编程:你可以快速跳转至依赖项的源代码,快速访问从 crate 导入的结构体或枚举的可用方法,而无需在编辑器和 docs.rs 之间不断切换。

IDE 设置主要有两个选项:rust-analyzer 和 IntelliJ Rust (现在叫做RustRover)

译者注: 当然我本人喜欢用Neovim + rust-analyzer, VS Code看起来也很不错的说

Rust-analyzer

rust-analyzer 是 Rust LSP (Language Server Protocol) 的一个实现。

LSP 使得在各种编辑器中轻松使用 rust-analyzer 变得容易

这意味着你可以在 VS Code、Emacs、Vim/NeoVim 和 Sublime Text 3获得相同的Rust开发体验

特定编辑器的设置说明可在此处找到

IntelliJ Rust/RustRover

IntelliJ Rust 为 JetBrains 开发的编辑器套件提供 Rust 支持。

如果您没有 JetBrains 许可证,可以免费使用支持 In从telliJ Rust 的 IntelliJ IDEA 社区版本

如果您拥有 JetBrains 许可证,那么 CLion 是您首选的 Rust 编辑器。 (译者注: 现在用RustRover的话会更合适的)

我该用哪个IDE

译者注: 本段疑似过时, 现在 rust-analyzer 看起来很稳定, 如果你介意专有软件的话, 建议使用 rust-analyzer + 任何一个支持LSP的编辑器

截至 2022 年 3 月,IntelliJ Rust 应为首选。

尽管 rust-analyzer 前景光明,并且在过去一年中取得了令人难以置信的进步,但它距离提供与 IntelliJ Rust 目前提供的 IDE 体验相当的体验还相去甚远。

另一方面,IntelliJ Rust 会强制您使用 JetBrains 的 IDE,而您可能愿意,也可能不愿意。如果您想继续使用您选择的编辑器,请寻找其 rust-analyzer 集成/插件。

值得一提的是,rust-analyzer 是 Rust 编译器内部正在进行的更大规模库化工作的一部分:rust-analyzer 和 rustc 之间存在重叠,存在大量重复工作。

将编译器的代码库演化为一组可重用的模块,将使 rust-analyzer 能够利用编译器代码库中越来越大的子集,从而释放提供一流 IDE 体验所需的按需分析功能。

这是一个值得未来关注的有趣空间

内部开发循环

在项目开发过程中,我们会反复执行相同的步骤:

- 进行修改

- 编译应用程序

- 运行测试

- 运行应用程序

这也称为内部开发循环。

内部开发循环的速度是单位时间内可以完成的迭代次数的上限。

如果编译和运行应用程序需要 5 分钟,那么每小时最多可以完成 12 次迭代。如果将其缩短到 2 分钟,那么每小时就可以完成 30 次迭代!

Rust 在这方面帮不上忙——编译速度可能会成为大型项目的痛点。在继续下一步之前,让我们看看可以采取哪些措施来缓解这个问题。

让链接 (Linking) 更快点

在考察内部开发循环时,我们主要关注增量编译的性能——在对源代码进行微小更改后,Cargo 需要多长时间来构建二进制文件。

链接阶段 会花费相当多的时间——根据早期编译阶段的输出来组装实际的二进制文件。

默认链接器的性能不错,但根据您使用的操作系统,还有其他更快的替代方案:

- Windows 和Linux上的 lld, LLVM 项目开发的链接器

- MacOS上的 zld

为了加快链接阶段,您必须在计算机上安装备用链接器,并将此配置文件添加到项目中:(别忘了安装链接器!)

# .cargo/config.toml

# On Windows

# ```

# cargo install -f cargo-binutils

# rustup component add llvm-tools-preview

# ```

[target.x86_64-pc-windows-msvc]

rustflags = ["-C", "link-arg=-fuse-ld=lld"]

[target.x86_64-pc-windows-gnu]

rustflags = ["-C", "link-arg=-fuse-ld=lld"]

# On Linux:

# - Ubuntu, `sudo apt-get install lld clang`

# - Arch, `sudo pacman -S lld clang`

[target.x86_64-unknown-linux-gnu]

rustflags = ["-C", "linker=clang", "-C", "link-arg=-fuse-ld=lld"]

# On MacOS, `brew install michaeleisel/zld/zld`

[target.x86_64-apple-darwin]

rustflags = ["-C", "link-arg=-fuse-ld=/usr/local/bin/zld"]

[target.aarch64-apple-darwin]

rustflags = ["-C", "link-arg=-fuse-ld=/usr/local/bin/zld"]

Rust 编译器目前正在努力尽可能使用 lld 作为默认链接器——很快,这种自定义配置将不再是实现更高编译性能的必需品!

cargo-watch

我们还可以通过减少感知编译时间(即您花在终端上等待 cargo check 或 cargo run 完成的时间)来减轻对生产力的影响。

有工具可以帮我们! 我们可以用这个命令来安装 cargo-watch

cargo install cargo-watch

cargo-watch 会监控你的源代码,并在文件每次更改时自动执行命令。例如:

cargo watch -x check

这个命令将在每次源代码发生变化的时候自动运行 cargo check

这会减少你的编译时间

- 您仍在 IDE 中,重新阅读刚刚所做的代码更改

- 与此同时,cargo-watch 已经启动了编译过程

- 切换到终端后,编译器已经运行了一半

cargo-watch 也支持命令链:

cargo watch -x check -x test -x run

- 它会先运行

cargo check - 如果成功,它会启动

cargo test - 如果测试通过,它会使用

cargo run启动应用程序。

我们的内部开发循环,就在这里!

持续集成

工具链已安装。 项目框架已完成。 IDE 已准备就绪。

在我们深入了解构建细节之前,最后要考虑的是我们的 持续集成 (CI) 流水线

在基于主干的开发中,我们应该能够在任何时间点部署主分支。

团队的每个成员都可以从主分支分支开发一个小功能或修复一个错误,然后合并回主分支并发布给用户。

持续集成使团队的每个成员能够每天多次将他们的更改集成到主分支中。

这会产生强大的连锁反应。

有些是显而易见且易于察觉的:它减少了由于长期分支而不得不处理混乱的合并冲突的机会。没有人喜欢合并冲突。

有些则更为微妙:持续集成可以缩短反馈循环。 你不太可能独自开发几天或几周,却发现你选择的方法并未得到团队其他成员的认可,或者无法与项目的其他部分很好地集成。

它迫使你尽早与同事沟通,并在必要时在仍然容易进行(并且不会冒犯任何人)的情况下进行纠正。

我们怎么让这些事情变得可能呢?

我们的 CI 流水线会在每次提交时运行一系列自动化检查。

如果其中一项检查失败,您将无法合并到主代码库 - 就这么简单。

CI 流水线通常不仅仅是确保代码健康:它们还是执行一系列其他重要检查的理想场所 - 例如,扫描依赖关系树以查找已知漏洞、进行 linting、格式化等等。

我们将逐一介绍您可能希望在 Rust 项目的 CI 流水线中运行的各种检查,并逐步介绍相关工具。 然后,我们将为一些主要的 CI 提供商提供一套现成的 CI 流水线。

CI 步骤

测试

如果您的 CI 流水线只有一个步骤,那么它应该是测试。

测试是 Rust 生态系统中的一流概念,您可以利用 cargo 来运行单元测试和集成测试:

cargo test

cargo test 还会在运行测试之前构建项目,因此您无需

事先运行 cargo build (尽管大多数流水线会在运行测试之前调用 cargo build 来缓存依赖项)。

代码覆盖率

关于测量代码覆盖率的利弊,已经有很多文章进行了探讨。

虽然使用代码覆盖率作为质量检查有一些缺点,但我确实认为它是一种快速收集信息并发现代码库中某些部分是否长期被忽视以及 测试是否不足的方法。 测量 Rust 项目代码覆盖率最简单的方法是使用 cargo tarpaulin,这是 xd009642 开发的 cargo 子命令。您可以使用以下命令安装 tarpaulin

# At the time of writing tarpaulin only supports

# x86_64 CPU architectures running Linux.

cargo install cargo-tarpaulin

当运行如下命令的时候, 将计算应用程序代码的代码覆盖率,忽略测试函数。 tarpaulin 可用于将代码覆盖率指标上传到 Codecov 或 Coveralls 等热门服务。

请参阅 tarpaulin 的 README 文件,了解如何上传代码覆盖率指标。

cargo tarpaulin --ignore-tests

代码检查 (Linting)

用任何编程语言编写符合风格的代码都需要时间和练习。

在学习初期,很容易遇到一些可以用更简单方法解决的问题,最终却得到相当复杂的解决方案。

静态分析可以提供帮助:就像编译器单步执行代码以确保其符合语言规则和约束一样,linter 会尝试识别不符合风格的代码、过于复杂的结构以及常见的错误/低效之处。

Rust 团队维护着 Clippy, 官方的 Rust Linter

如果您使用默认配置文件,clippy 会包含在 rustup 安装的组件集中。

CI 环境通常使用 rustup 的最小配置文件,其中不包含 clippy。

但是您可以使用以下命令来安装它

rustup component add clippy

如果你已经安装过 clippy 了, 执行这个命令什么也不会发生

你可以执行如下的命令来为你的项目运行 clippy

cargo clippy

在我们的 CI 管道中,如果 clippy 发出任何警告,我们希望 Linter 检查失败。

我们可以通过以下方式实现:

cargo clippy -- -D warnings

静态分析并非万无一失:有时 clippy 可能会建议一些你认为不正确或不理想的更改。

你可以在受影响的代码块上使用 #[allow(clippy::lint_name)] 属性来关闭特定的警告,

或者在 clippy.toml 中使用一行配置语句,为整个项目禁用干扰性的 lint 检查。

或使用项目级 #![allow(clippy::lint_name)] 宏。

有关可用的 lint 以及如何根据您的特定目的进行调整的详细信息,请参阅 clippy 的 README 文件。

代码格式化

大多数组织对主分支都有不止一道防线:

- 一道是 持续集成 (CI) 流水线检查

- 另一道通常是*拉取请求 (PR) 审查**

关于有价值的 PR 审查流程与枯燥乏味 PR 审查流程的区别,有很多说法——无需在此重新展开争论。

我确信好的 PR 审查不应该关注以下几点:格式上的小瑕疵——例如,"你能在这里加个换行符吗?"、"我觉得那里尾部有个空格!" 等等。

让机器处理格式,而审查人员则专注于架构、测试的完整性、可靠性和可观察性。自动格式化可以消除 PR 审查流程中复杂的干扰。你可能不喜欢这样或那样的格式选择,但彻底消除格式上的繁琐, 值得承受些许不适。

rustfmt 是 Rust 官方的格式化程序。

与 clippy 一样,rustfmt 也包含在 rustup 安装的默认组件中

您可以使用以下命令安装它

rustup component add rustfmt

你可以使用如下命令来为你的整个项目格式化代码

cargo fmt

在我们的 CI 流中,我们将添加格式化步骤

cargo fmt -- --check

如果提交包含未格式化的代码,它将失败,并将差异打印到控制台。

您可以使用配置文件 rustfmt.toml 针对项目调整 rustfmt。详细信息请参阅 rustfmt 的 README 文件。

安全漏洞

cargo 使得利用生态系统中现有的 crate 来解决当前问题变得非常容易。

另一方面,每个 crate 都可能隐藏可利用的漏洞,从而危及软件的安全状况。

Rust 安全代码工作组 (Rust Secure Code working group) 维护着一个 数据库,其中包含 crates.io 上发布的 crate 的最新漏洞报告。

他们还提供了 cargo-audit,这是一个便捷的 cargo 子命令,用于检查项目依赖关系树中是否有任何 crate 存在漏洞。

您可以使用以下命令安装它

cargo install cargo-audit

当你安装之后, 你可以执行如下命令来扫描你的依赖树

cargo audit

我们将在每次提交时运行 cargo-audit,作为 CI 流水线的一部分。

我们还将每天运行它,以随时掌握那些我们目前可能没有积极开发但仍在生产环境中运行的项目依赖项的新漏洞!

开箱即用的 CI 流

授人以鱼,不如授人以渔

希望我教给你的知识足以让你为你的 Rust 项目构建一个可靠的 CI 流水线。

我们也应该坦诚地承认,学习如何使用 CI 提供商所使用的特定配置语言可能需要花费数小时的反复尝试,而且调试过程通常非常痛苦,反馈周期也很长。

因此,我决定编写一套适用于最常用现成配置文件, —— 就是我们刚才描述的那些步骤,可以直接放到你的项目仓库中:

调整现有设置以满足您的特定需求通常比从头开始编写新设置要容易得多

写一个电子邮件新闻程序

我们的驱动示例

前言指出

“从零到生产”将重点关注由四到五名经验和熟练程度各异的工程师组成的团队编写云原生应用程序所面临的挑战。

怎么做? 嗯,那就亲手建造一个吧!

基于问题的学习

选择一个你想解决的问题。

让问题驱动新概念和新技术的引入。

它颠覆了你习惯的层级结构:你正在学习的材料并非因为有人声称它相关,而是因为有助于更接近解决方案。

你学习新技术,并知道何时应该学习它们。

细节决定成败:基于问题的学习路径可能令人愉悦,但人们很容易误判旅程中每一步的挑战程度。

我们驱动的示例需要:

- 足够小,以便我们能够在不偷工减料的情况下在一本书中解决;

- 足够复杂,以便涵盖大型系统中出现的大多数关键主题;

- 足够有趣,以便读者在学习过程中保持兴趣。

我们将采用电子邮件简报的形式——下一节将详细介绍我们计划涵盖的功能

纠正教程

基于问题的学习在互动环境中效果最佳:教师充当引导者,

根据参与者的行为线索和反应提供或多或少的支持。

在网站上出版的书籍无法给我同样的机会。

我非常感谢您对材料的反馈——请联系 contact@lpalmieri.com 或在推特上给我发送私信。

在现阶段,提供反馈是为“从零到生产”做出贡献的切实可行的方式。

我们的Newsletter应该做什么

有数十家公司提供的服务包含或主要围绕管理电子邮件地址列表这一理念。

虽然它们都拥有一些核心功能(例如发送电子邮件),但它们的服务都是针对特定用例量身定制的:面向管理数十万个地址且具有严格安全和合规要求的大公司的产品,与面向运营自有博客或小型在线商店的独立内容创作者的 SaaS 产品,在用户界面、营销策略和定价方面会有很大差异。

现在,我们并没有打造下一个 MailChimp 或 ConvertKit 的野心——它们的范围肯定太广,我们无法在一本书中全部涵盖。此外,一些功能需要反复应用相同的概念和技术——读久了会变得乏味。

如果您愿意在您的博客中添加一个电子邮件订阅页面——我们将尝试构建一个电子邮件通讯服务,以支持您起步所需的一切——不多不少,恰到好处。

捕捉需求: 用户故事

上面的产品简介留有一些解释空间——为了更好地界定我们的服务应该支持哪些内容,我们将利用用户故事。

格式相当简单:

- 作为一名...

- 我想...

- 这样...

用户故事可以帮助我们了解我们为谁构建(作为用户)、他们想要执行的操作(想要执行的操作)以及他们的动机(以便执行操作)。 我们将实现三个用户故事:

- 作为博客访问者, 我想订阅新闻简报, 以便在博客发布新内容时收到电子邮件更新

- 作为博客作者, 我想向所有订阅者发送电子邮件, 以便在发布新内容时通知他们

- 作为订阅者, 我想取消订阅新闻简报, 以便不再接收博客的电子邮件更新。

我们不会添加以下功能

- 管理多份新闻通讯

- 将订阅者细分为多个受众群体

- 跟踪打开率和点击率

如上所述,它相当简陋——尽管如此,足以满足大多数博客作者的需求。

它肯定也能满足我“从零到生产”的需求。

迭代工作

让我们看其中一个用户故事:

作为博客作者, 我想向所有订阅者发送一封电子邮件, 以便在新内容发布时通知他们。

这在实践中意味着什么? 我们需要构建什么?

一旦你开始仔细研究这个问题, 就会出现大量问题——例如, 我们如何确保调用者确实是博客作者? 我们是否需要引入身份验证机制?

我们应该在电子邮件中支持 HTML 格式还是只支持纯文本? 那关于表情符号呢?

我们很容易花费数月时间来实现一个极其完善的电子邮件传递系统, 而甚至连基本的订阅/取消订阅功能都没有。

我们可能成为发送电子邮件领域的佼佼者, 但没有人会使用我们的电子邮件简报服务,因为它无法覆盖整个流程。

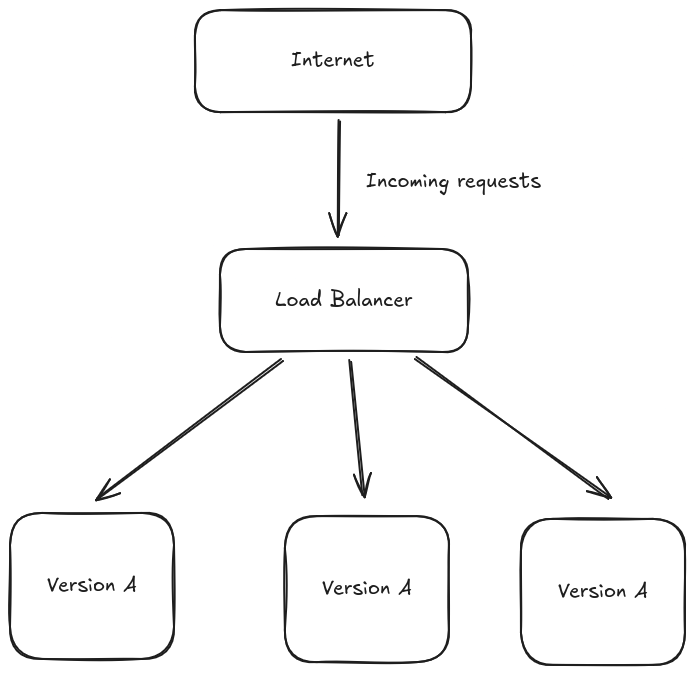

我们不会深入研究某个故事, 而是尝试在第一个版本中构建足够多的功能, 以在一定程度上满足所有故事的需求。

然后, 我们会回过头来改进: 为电子邮件发送添加容错和重试功能, 为新订阅者添加确认电子邮件等。

我们将以迭代的方式工作: 每次迭代都需要固定的时间, 并为我们带来略微更好的产品版本, 从而提升用户的体验。

值得强调的是, 我们迭代的是产品功能, 而不是工程质量:每次迭代生成的代码都会经过测试并妥善记录, 即使它只提供了一个微小但功能齐全的功能。

接下来

策略清晰, 我们终于可以开始了:下一章将重点介绍订阅功能。

起步阶段需要完成一些繁重的工作: 选择 Web 框架, 搭建用于管理数据库迁移的基础设施, 搭建应用程序脚手架, 以及设置集成测试。

预计以后会花更多时间与编译器进行结对编程!

注册新用户

- 我们的策略

- 选择一个Web框架

- 我们的第一个Endpoint - 简单的可用性检测

- 我们的第一个集成测试

- 实现我们的第一个集成测试

- 回顾

- 使用HTML表单

- 存储数据: 数据库

- 持久化新订阅者

- 更新我们的测试

- 小结

我们的策略

我们将从头开始一个新项目——我们需要处理大量前期繁重的工作:

- 选择一个 Web 框架并熟悉它;

- 定义我们的测试策略;

- 选择一个 crate 与我们的数据库交互(我们需要将这些电子邮件保存在某个地方!);

- 定义我们希望如何管理数据库模式随时间的变化(也就是迁移);

- 实际编写一些查询。

这项工作非常繁重,如果一头扎进去可能会让人不知所措。

我们将添加一个垫脚石,使整个过程更容易理解:在处理 /subscriptions 之前,我们将实现一个 /health_check 端点。虽然没有业务逻辑,但这是一个很好的机会,让我们熟悉我们的 Web 框架,并了解其所有不同的组成部分。

我们将依靠我们的持续集成流水线来在整个过程中保持控制——如果您尚未设置它,请快速浏览 第一章(或获取一个现成的模板)。

选择一个Web框架

我们应该使用哪个 Web 框架来编写 Rust API?

这部分原本应该讨论当前可用的 Rust Web 框架的优缺点。

但最终篇幅过长,实在没必要在这里写,所以我把它作为一篇衍生文章发布:请参阅 《选择 Rust Web 框架,2020 版》 (英语),深入了解 actix-web、rocket、tide 和 warp

简而言之:截至 2022 年 3 月,actix-web 应该是您在生产环境中使用 Rust API 时的首选 Web 框架——它在过去几年中得到了广泛的使用,拥有庞大而健康的社区,并且运行在 tokio 上,因此最大限度地减少了处理不同异步运行时之间不兼容/互操作的可能性。

因此,它将成为我们从零到生产环境的首选。

尽管如此,tide、rocket和wrap都拥有巨大的潜力,我们最终可能会在2022年晚些时候做出不同的决定——如果你正在使用不同的框架进行“从零到生产”的实践,我很乐意看看你的代码!请给原作者发邮件至 contact@lpalmieri.com

在本章及以后的内容中,我建议您打开几个额外的浏览器标签页:actix-web 的网站、actix-web 的文档和 actix-web 的示例集。

我们的第一个Endpoint - 简单的可用性检测

让我们尝试通过实现一个健康检查端点来开始:当我们收到对 /health_check 的 GET 请求时,我们希望返回一个不带正文的 200 OK 响应。

我们可以使用 /health_check 来验证应用程序是否已启动并准备好接受传入请求。

将它与 pingdom.com 这样的 SaaS 服务结合使用,您可以在 API 出现故障时收到警报——这对于您正在运行的电子邮件简报来说是一个很好的基准。

如果您使用容器编排器 (例如 Kubernetes 或 Nomad)来协调您的应用程序,那么健康检查端点也会非常方便:编排器可以调用 /health_check 来检测 API 是否无响应并触发重启。

编写 Actix-Web

我们的起点是 actix-web 主页上的 Hello World!示例:

use actix_web::{App, HttpRequest, HttpServer, Responder, web};

async fn greet(req: HttpRequest) -> impl Responder {

let name = req.match_info().get("name").unwrap_or("World");

format!("Hello {}!", &name)

}

#[tokio::main]

async fn main() -> std::io::Result<()> {

HttpServer::new(|| {

App::new()

.route("/", web::get().to(greet))

.route("/{name}", web::get().to(greet))

})

.bind("127.0.0.1:8000")?

.run()

.await

}

让我们把示例代码粘贴到 main.rs中

让我们运行 cargo check

error[E0432]: unresolved import `actix_web`

--> src/main.rs:1:5

|

1 | use actix_web::{App, HttpRequest, HttpServer, Responder, web};

| ^^^^^^^^^ use of unresolved module or unlinked crate `actix_web`

|

= help: if you wanted to use a crate named `actix_web`, use `cargo add actix_web` to add it to your `Cargo.toml`

error[E0433]: failed to resolve: use of unresolved module or unlinked crate `tokio`

--> src/main.rs:8:3

|

8 | #[tokio::main]

| ^^^^^ use of unresolved module or unlinked crate `tokio`

Some errors have detailed explanations: E0432, E0433.

For more information about an error, try `rustc --explain E0432`.

等..等等...为什么会这样

我们尚未将 actix-web 和 tokio 添加到依赖项列表中,因此编译器无法解析我们导入的内容。

我们可以手动修复此问题,方法是在 Cargo.toml 中添加

#! Cargo.toml

# [...]

[dependencies]

actix-web = "4"

tokio = { version = "1", features = ["macros", "rt-multi-thread"] }

或许我们可以执行 cargo add actix-web 来快速添加 actix-web 依赖

让我们再次运行 cargo check! 现在应该一切正常了!

让我们尝试运行一下应用程序!

cargo run

在你喜欢的终端尝试一下API吧

curl http://127.0.0.1:8000

太好了! 这可以用!

现在, 你可以按下 Ctrl+C来停止web应用程序

actix-web 应用程序的剖析

现在让我们回过头仔细看看我们刚刚在 main.rs 文件中复制粘贴的内容。

//! src/main.rs

// [...]

#[tokio::main]

async fn main() -> std::io::Result<()> {

HttpServer::new(|| {

App::new()

.route("/", web::get().to(greet))

.route("/{name}", web::get().to(greet))

})

.bind("127.0.0.1:8000")?

.run()

.await

}

服务器 - HttpServer

HttpServer 是支撑我们应用程序的骨干。它负责处理以下事项:

- 应用程序应该在哪里监听传入的请求?TCP socket (例如 127.0.0.1:8000)? Unix 域套接字?

- 我们应该允许的最大并发连接数是多少?单位时间内可以创建多少个新连接?

- 我们应该启用传输层安全性 (TLS) 吗?

- 等等

换句话说,HttpServer 处理所有传输层的问题。

之后会发生什么?当 HttpServer 与我们的 API 客户端建立了新的连接,而我们需要开始处理他们的请求时,它会做什么?

这时,App 就派上用场了!

应用程序 - App

App 是所有应用逻辑的存放地:路由、中间件、请求处理程序等。

App 组件的作用是接收传入的请求并返回响应。

让我们仔细地看一下如下代码片段:

App::new()

.route("/", web::get().to(greet))

.route("/{name}", web::get().to(greet))

App 是builder模式的一个实际示例: new() 为我们提供了一个干净的平台,我们可以使用流畅的 API(即链式调用)一点一点地添加新的行为。

我们将在整本书中根据需要了解 App 的大部分 API 接口: 读完本书后,您应该至少接触过一次它的大多数方法。

端点 - Route

如何向我们的应用添加新的端点?route 方法可能是最简单的方法 ——毕竟,我们已经在 Hello World! 示例中使用过了!

route 方法接受两个参数:

path- 一个字符串,可能为模板(例如/{name}), 用于容纳动态路径route- Route 结构体的实例

Route 将处理程序与一组守卫组合在一起。

守卫指定请求必须满足的条件才能“匹配”并传递给处理程序。从实现的角度来看,守卫是 Guard 特性的实现者:

Guard::check 是奇迹发生的地方。

在我们的代码片段中

.route("/", web::get().to(greet))

"/" 将匹配所有在基本路径后不带任何段的请求,例如 http://localhost:8000/。

web::get() 是 Route::new().guard(guard::Get()) 的快捷方式,也就是说,当且仅当请求的 HTTP 方法是 GET 时,该请求才会传递给处理程序。

您可以想象一下,当一个新请求到来时会发生什么:应用会遍历所有已注册的端点,直到找到一个匹配的端点(路径模板和保护条件都满足),然后将请求对象传递给处理程序。

这并非 100% 准确,但目前来说,这是一个足够好的思维模型。

处理程序应该是什么样的?它的函数签名是什么?

目前我们只有一个示例,greet:

async fn greet(req: HttpRequest) -> impl Responder {

// [...]

}

运行时 - Tokio

我们从整个 HttpServer 深入到 Route。让我们再看一下整个 main 函数:

#[tokio::main]

async fn main() -> std::io::Result<()> {

// [...]

}

#[tokio::main] 有什么用? 当然, 让我们删掉它看看会发生什么!

很不幸的, cargo check 给出了如下的报错

error[E0752]: `main` function is not allowed to be `async`

--> src/main.rs:9:1

|

9 | async fn main() -> std::io::Result<()> {

| ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^ `main` function is not allowed to be `async`

For more information about this error, try `rustc --explain E0752`.

error: could not compile `zero2prod` (bin "zero2prod") due to 1 previous error

我们需要 main 函数是异步的,因为 HttpServer::run 是一个异步方法,但 main 函数(我们二进制文件的入口点)不能是异步函数。为什么呢?

Rust 中的异步编程建立在 Future trait 之上: Future 代表一个可能尚未到达的值。所有 Future 都公开一个 poll 方法,必须调用该方法才能使 Future 继续执行并最终解析出最终值。你可以将 Rust 的 Future 视为惰性的:除非进行轮询,否则无法保证它们会执行完成。与其他语言采用的推送模型相比,这通常被描述为一种拉模型。

Rust 的标准库在设计上不包含异步运行时:你应该将其作为依赖项引入你的项目,在 Cargo.toml 文件的 [dependencies] 下添加一个 crate。这种方法非常灵活:您可以自由地实现自己的运行时,并根据用例的特定需求进行优化(参见 Fuchsia 项目或 bastion 的 Actor 框架)。

这就解释了为什么 main 不能是异步函数:谁负责调用它的 poll 方法?

没有特殊的配置语法来告诉 Rust 编译器你的依赖项之一是异步运行时(例如,我们对分配器所做的配置),而且,公平地说,甚至没有一个关于运行时的标准化定义(例如,Executor trait)。 因此,你应该在 main 函数的顶部启动异步运行时,

然后用它来驱动你的 Future 完成。

你现在可能已经猜到 #[tokio::main] 的用途了,但仅仅猜测是不够的:

我们想看到它。

但是怎么做呢?

tokio::main 是一个过程宏,这是一个引入 cargo expand 的绝佳机会,它对于 Rust 开发来说是一个很棒的补充:

cargo install cargo-expand

Rust 宏在 token 级别运行:它们接收一个符号流(例如,在我们的例子中是整个 main 函数),并输出一个新符号流,然后将其传递给编译器。换句话说,Rust 宏的主要用途是代码生成。

我们如何调试或检查特定宏的运行情况?您可以检查它输出的 token!

这正是 cargo expand 的亮点所在:它会扩展代码中的所有宏,而无需将输出传递给编译器,让您可以单步执行并了解正在发生的事情。

让我们使用 cargo expand 来揭开 #[tokio::main] 的神秘面纱:

cargo expand

fn main() -> std::io::Result<()> {

let body = async { run().await };

#[allow(

clippy::expect_used,

clippy::diverging_sub_expression,

clippy::needless_return

)]

{

return tokio::runtime::Builder::new_multi_thread()

.enable_all()

.build()

.expect("Failed building the Runtime")

.block_on(body);

}

}

我们终于可以看看宏扩展后的代码了!

#[tokio::main] 扩展后传递给 Rust 编译器的 main 函数

确实是同步 (Sync) 的, 这也解释了为什么它编译时没有任何问题。

关键的一行是:tokio::runtime::Builder::new_multi_thread().enable_all().build().expect("[...]").block_on(/*[...]*/)

我们正在启动 tokio 的异步运行时,并使用它来驱动 HttpServer::run 返回的 Future 完成。

换句话说,#[tokio::main] 的作用是让我们产生能够定义异步主函数的错觉,而实际上,它只是获取我们的主要异步代码,并编写必要的样板代码,使其在 tokio 的运行时之上运行。

实现 Health Check Handler

我们已经回顾了 actix_web 的 Hello World! 示例中所有需要移动的部分:HttpServer、App、route 和 actix_web::main。

我们当然已经了解了足够多的内容,可以修改示例,使健康检查能够按预期工作:

在 /health_check 收到 GET 请求时,返回一个不带正文的 200 OK 响应。

让我们重新回顾一下我们的起点:

use actix_web::{App, HttpRequest, HttpServer, Responder, web};

async fn greet(req: HttpRequest) -> impl Responder {

let name = req.match_info().get("name").unwrap_or("World");

format!("Hello {}!", &name)

}

#[tokio::main]

async fn main() -> std::io::Result<()> {

HttpServer::new(|| {

App::new()

.route("/", web::get().to(greet))

.route("/{name}", web::get().to(greet))

})

.bind("127.0.0.1:8000")?

.run()

.await

}

首先,我们需要一个请求处理程序。模仿 greet 函数,我们可以从以下签名开始:

async fn health_check(req: HttpRequest) -> impl Responder {

todo!()

}

我们说过,Responder 只不过是一个转换为 HttpResponse 的 trait。那么直接返回一个 HttpResponse 实例应该就行了!

查看它的文档,我们可以使用 HttpResponse::Ok 来获取一个已准备好 200 状态码的 HttpResponseBuilder。HttpResponseBuilder 提供了一个丰富的流畅 API,可以逐步构建 HttpResponse 响应,但我们在这里不需要它: 我们可以通过在构建器上调用 finish 来获取一个带有空主体的 HttpResponse。

将所有内容结合在一起:

use actix_web::{HttpRequest, HttpResponse, Responder};

// [...]

async fn health_check(req: HttpRequest) -> impl Responder {

HttpResponse::Ok().finish()

}

快速运行一下 cargo check,确认我们的处理程序没有做任何奇怪的事情。

仔细查看一下 HttpResponseBuilder 的定义, 会发现它也实现了 Responder 接口——因此,我们可以省略对 finish 的调用,并将处理程序简化为:

// [...]

async fn health_check(req: HttpRequest) -> impl Responder {

HttpResponse::Ok()

}

下一步是处理程序注册 - 我们需要通过 route 将其添加到我们的 App 中: (别忘了删除示例中的greet方法和相关route注册的代码)

//! src/main.rs

// [...]

#[tokio::main]

async fn main() -> std::io::Result<()> {

// [...]

App::new()

// [...]

.route("/health_check", web::get().to(health_check))

// [...]

}

现在我们的代码看起来是这样

use actix_web::{web, App, HttpRequest, HttpResponse, HttpServer, Responder};

async fn health_check(req: HttpRequest) -> impl Responder {

HttpResponse::Ok()

}

#[tokio::main]

async fn main() -> std::io::Result<()> {

HttpServer::new(|| {

App::new()

.route("/health_check", web::get().to(health_check))

})

.bind("127.0.0.1:8000")?

.run()

.await

}

你可能看到 cargo check 在抱怨变量 req没有用到

我们的健康检查响应确实是静态的,并且不使用任何与传入 HTTP 请求捆绑的数据(路由除外)。我们可以遵循编译器的建议,在 req 前添加下划线...... 或者,我们可以从 health_check 中完全删除该输入参数:

async fn health_check() -> impl Responder {

HttpResponse::Ok()

}

惊喜啊,它编译通过了!actix-web 在后台运行着一些相当高级的类型处理程序, 并且它接受各种各样的签名作为请求处理程序——稍后会详细介绍。

接下来做什么?

好吧,来个小测试!

curl -v http://127.0.0.1:8000/health_check

$ curl -v http://127.0.0.1:8000/health_check

* Trying 127.0.0.1:8000...

* Connected to 127.0.0.1 (127.0.0.1) port 8000

* using HTTP/1.x

> GET /health_check HTTP/1.1

> Host: 127.0.0.1:8000

> User-Agent: curl/8.15.0

> Accept: */*

>

* Request completely sent off

< HTTP/1.1 200 OK

< content-length: 0

< date: Wed, 20 Aug 2025 06:36:57 GMT

<

* Connection #0 to host 127.0.0.1 left intact

你现在应该可以在响应中看到类似HTTP/1.1 200 OK的字样

这太棒了! 我们的Health Check正在工作!

恭喜你实现了第一个 actix-web 端点!

我们的第一个集成测试

/health_check 是我们的第一个端点,我们通过启动应用程序并通过 curl 手动测试来验证一切是否按预期运行。

然而,手动测试非常耗时: 随着应用程序规模的扩大,每次执行更改时,手动检查我们对其行为的所有假设是否仍然有效,成本会越来越高。

我们希望尽可能地实现自动化: 这些检查应该在每次提交更改时都在我们的持续集成 (CI) 流水线中运行,以防止出现回归问题。

虽然健康检查的行为在整个过程中可能不会有太大变化,但它是正确设置测试框架的良好起点。

我应该怎么测试一个API Endpoint

API 是达到目的的手段:一种暴露给外界执行某种任务的工具(例如,存储文档、发布电子邮件等)。

我们在 API 中暴露的端点定义了我们与客户端之间的契约:关于系统输入和输出(即接口)的共同协议。

契约可能会随着时间的推移而演变,我们可以粗略地设想两种情况:

- 向后兼容的变更(例如,添加新的端点)

- 重大变更(例如,移除端点或从其输出的架构中删除字段)。

在第一种情况下,现有的 API 客户端将保持原样运行。在第二种情况下,如果现有的集成依赖于契约中被违反的部分,则可能会中断。

虽然我们可能会故意部署对 API 契约的重大变更,但至关重要的是,我们不要意外地破坏它。

什么是最可靠的方法来检查我们没有引入用户可见的回归?

通过与用户完全一样的方式与 API 交互来测试 API:向 API 执行 HTTP 请求,并验证我们对收到的响应的假设。

这通常被称为黑盒测试:我们通过检查系统的输出来验证系统的行为,而不需要了解其内部实现的细节。

遵循这一原则,我们不会满足于直接调用处理函数的测试——例如:

#[cfg(test)]

mod tests {

use crate::health_check;

#[tokio::test]

async fn health_check_succeeds() {

let response = health_check().await;

// This requires changing the return type of `health_check`

// from `impl Responder` to `HttpResponse` to compile

// You also need to import it with `use actix_web::HttpResponse`!

assert!(response.status().is_success())

}

}

这样做并不是最佳实践

- 我们没有检查处理程序是否在 GET 请求时调用

- 我们也没有检查处理程序是否以 /health_check 作为路径调用。

更改这两个属性中的任何一个都会破坏我们的 API 契约,但我们的测试仍然会通过—— 这还不够好。

actix-web 提供了一些便利,可以在不跳过路由逻辑的情况下与应用进行交互, 但这种方法存在严重的缺陷:

- 迁移到另一个 Web 框架将迫使我们重写整个集成测试套件。 我们希望集成测试尽可能与 API 实现的底层技术高度分离(例如,在进行大规模重写或重构时,进行与框架无关的集成测试可以起到至关重要的作用!)

- 由于 actix-web 的一些限制,我们无法在生产代码和测试代码之间共享应用启动逻辑,因此,由于存在随着时间的推移出现分歧的风险,我们对测试套件提供的保证的信任度会降低。

我们将选择一个完全黑盒解决方案:我们将在每次测试开始时启动我们的应用程序,并使用现成的 HTTP 客户端 (例如 reqwest) 与其交互。

我应该把测试放在哪里

Rust 在编写测试时提供了三种选择:

- 在嵌入式测试模块中的代码旁边 (使用

mod tests)

// Some code I want to test

#[cfg(test)]

mod tests {

// Import the code I want to test

use super::*;

// My tests

}

- 在外部的

tests/文件夹

$ ls

src/

tests/

Cargo.toml

Cargo.lock

- 公共文档的一部分 (doc tests)

/// Check if a number is even.

/// ```rust

/// use zero2prod::is_even;

///

/// assert!(is_even(2));

/// assert!(!is_even(1));

/// ```

pub fn is_even(x: u64) -> bool {

x % 2 == 0

}

有什么区别?

嵌入式测试模块是项目的一部分,只是隐藏在配置条件检查 #[cfg(test)] 后面。而 tests 文件夹下的所有内容以及文档测试则被编译成各自独立的二进制文件。

这会影响可见性规则。

嵌入式测试模块对其相邻的代码拥有特权访问权:它可以与未标记为公共的结构体、方法、字段和函数进行交互,而这些内容通常无法被我们代码的用户访问,即使他们将其作为自己项目的依赖项导入也是如此。

嵌入式测试模块对于我所说的“冰山项目”非常有用,即暴露的接口非常有限(例如几个公共函数),但底层机制却非常庞大且相当复杂(例如数十个例程)。通过公开的函数来测试所有可能的边缘情况可能并非易事——您可以利用嵌入式测试模块为私有子组件编写单元测试,从而增强对整个项目正确性的整体信心。

而外部测试文件夹和文档测试对代码的访问级别,与将 crate 添加为另一个项目依赖项时获得的访问级别完全相同。因此,它们主要用于集成测试,即通过与用户完全相同的方式调用代码来测试。

我们的电子邮件简报并非库,因此两者之间的界限有点模糊——我们不会将其作为 Rust crate 公开给世界,而是将其作为可通过网络访问的 API 公开。

尽管如此,我们将使用 tests 文件夹进行 API 集成测试——它更加清晰地划分,并且将测试助手作为外部测试二进制文件的子模块进行管理也更加容易。

改变我们的项目结构以便于测试

在真正开始在 /tests 下编写第一个测试之前,我们还有一些准备工作要做。

正如我们所说,任何测试代码最终都会被编译成它自己的二进制文件——我们所有测试代码

都以 crate 的形式导入。但目前我们的项目是一个二进制文件:它旨在执行,而不是

共享。因此,我们无法像现在这样在测试中导入 main 函数。

如果您不相信我的话,我们可以做一个快速实验:

# Create the tests folder

mkdir -p tests

创建 tests/health_check.rs 然后写入如下代码

//! tests/health_check.rs

use zero2prod::main;

#[test]

fn dummy_test() {

main()

}

现在执行 cargo test, 欸? 好像报错了

error[E0432]: unresolved import `zero2prod`

--> tests/health_check.rs:1:5

|

1 | use zero2prod::main;

| ^^^^^^^^^ use of unresolved module or unlinked crate `zero2prod`

|

= help: if you wanted to use a crate named `zero2prod`, use `cargo add zero2prod` to add it to your `Cargo.toml`

For more information about this error, try `rustc --explain E0432`.

error: could not compile `zero2prod` (test "health_check") due to 1 previous error

译者注: 原作此处为修改 Cargo.toml来配置lib.rs, 但在最新的Rust中, lib.rs会自动识别为一个crate, 所以不必那么做了, 这里就没翻译

接下来我们创建文件 src/lib.rs

然后我们可以把 main.rs 中的逻辑搬过去了

//! main.rs

use zero2prod::run;

#[tokio::main]

async fn main() -> std::io::Result<()> {

run().await

}

//! lib.rs

use actix_web::{App, HttpResponse, HttpServer, Responder, web};

async fn health_check() -> impl Responder {

HttpResponse::Ok()

}

pub async fn run() -> std::io::Result<()> {

HttpServer::new(|| App::new().route("/health_check", web::get().to(health_check)))

.bind("127.0.0.1:8000")?

.run()

.await

}

好了,我们准备编写一些有趣的集成测试!

实现我们的第一个集成测试

我们对健康检查端点的规范是:当我们收到 /health_check 的 GET 请求时,我们会返回没有正文的 200 OK 响应。

这分为这几个部分

- GET 请求

- /health_check 端点

- 响应码 200

- 没有正文的响应

让我们将其转化为测试,并尽可能多地描述特征:

//! tests/health_check.rs

// `tokio::test` is the testing equivalent of `tokio::main`.

// It also spares you from having to specify the `#[test]` attribute.

//

// You can inspect what code gets generated using

// `cargo expand --test health_check` (<- name of the test file)

#[tokio::test]

async fn health_check_works() {

// Arrange

spawn_app().await.expect("Failed to spawn our app.");

// We need to bring in `reqwest`

// to perform HTTP requests against our application.

let client = reqwest::Client::new();

// Act

let response = client

.get("http://127.0.0.1:8000/health_check")

.send()

.await

.expect("Failed to execute request.");

// Assert

assert!(response.status().is_success());

assert_eq!(Some(0), response.content_length());

}

async fn spawn_app() -> std::io::Result<()> {

todo!()

}

当然别忘了添加 reqwest 依赖

cargo add reqwest --dev

请花点时间仔细看看这个测试用例。

spawn_app 是唯一一个合理地依赖于我们应用程序代码的部分。

其他所有内容都与底层实现细节完全解耦——如果明天我们决定放弃 Rust,用 Ruby on Rails 重写应用程序,我们仍然可以使用相同的测试套件来检查新堆栈中的回归问题,只要将 spawn_app 替换为合适的触发器(例如,使用 bash 命令启动 Rails 应用程序)。

该测试还涵盖了我们感兴趣的所有属性:

- 健康检查暴露在 /health_check;

- 健康检查使用 GET 方法;

- 健康检查始终返回 200;

- 健康检查的响应没有正文。

如果这个测试通过了,这就完成了。

测试还没来得及做任何有用的事情就崩溃了:我们缺少了 spawn_app,这是集成测试的最后一块拼图。

为什么我们不直接在那里调用 run 呢? 也就是说

async fn spawn_app() -> std::io::Result<()> {

zero2prod::run().await

}

让我们试试看!

cargo test

无论等待多久,测试执行都不会终止。这是怎么回事?

在 zero2prod::run 中,我们调用(并等待)HttpServer::run。HttpServer::run 返回一个 Server 实例 - 当我们调用 .await 时,它会无限期地监听我们指定的地址:它会处理传入的请求,但永远不会自行关闭或“完成”。

这意味着 spawn_app 永远不会返回,我们的测试逻辑也永远不会执行。

我们需要将应用程序作为后台任务运行。

tokio::spawn 在这里非常方便:tokio::spawn 接受一个 Future 并将其交给运行时进行轮询,

而无需等待其完成;因此,它与下游 Future 和任务(例如我们的测试逻辑)并发运行。

让我们重构 zero2prod::run,使其返回一个 Server 实例而不等待它:

//! src/lib.rs

// [...]

// Notice the different signature!

// We return `Server` on the happy path and we dropped the `async` keyword

// We have no .await call, so it is not needed anymore.

pub fn run() -> Result<Server, std::io::Error> {

let server = HttpServer::new(|| App::new().route("/health_check", web::get().to(health_check)))

.bind("127.0.0.1:8000")?

.run();

// No .await here!

Ok(server)

}

我们需要相应地修改我们的 main.rs:

//! src/main.rs

use zero2prod::run;

#[tokio::main]

async fn main() -> std::io::Result<()> {

run()?.await

}

运行一下 cargo check 应该能让我们确信一切正常。

现在我们可以实现 spawn_app 方法

// No .await call, therefore no need for `spawn_app` to be async now.

// We are also running tests, so it is not worth it to propagate errors:

// if we fail to perform the required setup we can just panic and crash

// all the things.

fn spawn_app() {

let server = zero2prod::run().expect("Failed to bind address");

// Launch the server as a background task

// tokio::spawn returns a handle to the spawned future,

// but we have no use for it here, hence the non-binding let

let _ = tokio::spawn(server);

}

快速调整我们的测试以适应 spawn_app 方法签名的变化:

#[tokio::test]

async fn health_check_works() {

// [...]

spawn_app();

// [...]

现在是时候运行 cargo test 了!

running 1 test

test health_check_works ... ok

test result: ok. 1 passed; 0 failed; 0 ignored; 0 measured; 0 filtered out; finished in 0.03s

耶!我们的第一次集成测试通过了!

替我给自己鼓个掌,在一个章节内完成了第二个重要的里程碑。

Polishing

我们已经让它运行起来了,现在我们需要重新审视并改进它,如果需要或可能的话

清理

测试运行结束后,后台运行的应用会发生什么?

它会关闭吗? 它会像僵尸程序一样徘徊在某个地方吗?

嗯,连续多次运行 cargo test 总是会成功——这强烈暗示我们的 8000 端口会在每次运行结束时被释放,因此意味着应用已正确关闭。

再次查看 tokio::spawn 的文档,这支持了我们的假设:当一个 tokio 运行时关闭时,所有在其上生成的任务都会被丢弃。tokio::test 会在每个测试用例开始时启动一个新的运行时,并在每个测试用例结束时关闭。

换句话说,好消息是——无需实现任何清理逻辑来避免测试运行期间的资源泄漏。

选择随机端口

spawn_app 总是会尝试在 8000 端口上运行我们的应用——这并不理想:

- 如果 8000 端口正在被我们机器上的其他程序(例如我们自己的应用!)占用,测试就会失败;

- 如果我们尝试并行运行两个或多个测试,那么只有一个测试能够绑定端口,其他所有测试都会失败。

我们可以做得更好: 测试应该在随机可用的端口上运行它们的后台应用。

首先,我们需要修改 run 函数——它应该将应用地址作为参数,而不是依赖于硬编码的值:

让我们修改 lib.rs

//! src/lib.rs

// [...]

pub fn run(address: &str) -> Result<Server, std::io::Error> {

let server = HttpServer::new(|| App::new().route("/health_check", web::get().to(health_check)))

.bind(address)?

.run();

// No .await here!

Ok(server)

}

然后,所有 zero2prod::run() 调用都必须更改为 zero2prod::run("127.0.0.1:8000") 才能保留相同的行为并使项目再次编译。

我们如何为测试找到一个随机可用的端口?

操作系统可以帮上忙:我们将使用端口 0。

端口 0 在操作系统层面是特殊情况:尝试绑定端口 0 将触发操作系统扫描可用端口,

然后该端口将被绑定到应用程序。

因此,只需将 spawn_app 更改为

//! tests/health_check.rs

fn spawn_app() {

let server = zero2prod::run("127.0.0.1:0").expect("Failed to bind address");

let _ = tokio::spawn(server);

}

注: 原作这里忘了提到要修改 main.rs 了, 请暂时将 main.rs 中的代码修改为

run("127.0.0.1:8000")?.await

这样就好了~ 现在,每次启动 Cargo 测试时,后台应用都会在随机端口上运行! 只有一个小问题...... 我们的测试失败了

running 1 test

test health_check_works ... FAILED

failures:

---- health_check_works stdout ----

thread 'health_check_works' panicked at tests/health_check.rs:19:10:

Failed to execute request.: reqwest::Error { kind: Request, url: "http://127.0.0.1:8000/health_check", source: hyper_util::client::legacy::Error(Connect, ConnectError("tcp connect error", 127.0.0.1:80

00, Os { code: 111, kind: ConnectionRefused, message: "Connection refused" })) }

note: run with `RUST_BACKTRACE=1` environment variable to display a backtrace

failures:

health_check_works

test result: FAILED. 0 passed; 1 failed; 0 ignored; 0 measured; 0 filtered out; finished in 0.02s

我们的 HTTP 客户端仍在调用 127.0.0.1:8000,我们现在真的不知道该在那里放什么: 应用程序端口是在运行时确定的,我们无法在那里进行硬编码。

我们需要以某种方式找出操作系统分配给我们应用程序的端口,并将其从 spawn_app 返回。

有几种方法可以实现这一点——我们将使用 std::net::TcpListener。

我们的 HttpServer 目前承担着双重任务:给定一个地址,它会绑定它,然后启动应用程序。我们可以接手第一步:我们自己用 TcpListener 绑定端口,然后使用 listen 将其交给 HttpServer。

这样做有什么好处呢?

TcpListener::local_addr 返回一个 SocketAddr 对象,它暴露了我们通过 .port() 绑定的实际端口。

让我们从 run 函数开始:

//! src/lib.rs

// [...]

pub fn run(listener: TcpListener) -> Result<Server, std::io::Error> {

let server = HttpServer::new(|| App::new().route("/health_check", web::get().to(health_check)))

.listen(listener)?

.run();

Ok(server)

}

这项更改破坏了我们的 main 函数和 spawn_app 函数。main 函数就留给你处理吧,我们来重点处理 spawn_app 函数:

//! tests/health_check.rs

// [...]

fn spawn_app() -> String {

let listener = TcpListener::bind("127.0.0.1:0").expect("Failed to bind random port");

// We retrieve the port assigned to us by the OS

let port = listener.local_addr().unwrap().port();

let server = zero2prod::run(listener).expect("Failed to bind address");

let _ = tokio::spawn(server);

// We return the application address to the caller!

format!("http://127.0.0.1:{}", port)

}

现在我们可以在 reqwest::Client 中引用这个地址:

//! tests/health_check.rs

// [...]

#[tokio::test]

async fn health_check_works() {

// Arrange

let address = spawn_app();

let client = reqwest::Client::new();

// Act

let response = client

// Use the returned application address

.get(format!("{address}/health_check"))

.send()

.await

.expect("Failed to execute request.");

// Assert

assert!(response.status().is_success());

assert_eq!(Some(0), response.content_length());

}

// [...]

回顾

让我们稍事休息一下,回顾一下,我们已经完成了相当多的内容!

我们着手实现一个 /health_check 端点,这让我们有机会进一步了解我们的 Web 框架 actix-web 的基础知识,以及 Rust API 的(集成)测试基础知识。

现在是时候利用我们学到的知识,最终完成我们电子邮件通讯项目的第一个用户故事了:

作为博客访问者, 我想订阅新闻简报, 以便在博客发布新内容时收到电子邮件更新

我们希望博客访问者在网页嵌入的表单中输入他们的电子邮件地址。

该表单将触发对我们后端 API 的 POST /subscriptions 调用,后端 API 将实际处理信息、存储信息并返回响应。

我们将深入研究:

- 如何在 actix-web 中读取 HTML 表单中收集的数据(例如,如何解析 POST 请求体?);

- 哪些库可以在 Rust 中使用 PostgreSQL 数据库(diesel、sqlx 和 tokio-postgres);

- 如何设置和管理数据库迁移;

- 如何在 API 请求处理程序中获取数据库连接;

- 如何在集成测试中测试副作用(即存储数据);

- 如何避免在使用数据库时测试之间出现奇怪的交互。

让我们开始吧!

使用HTML表单

完善我们的要求

为了将访客注册为我们的电子邮件简报,我们应该收集哪些信息?

嗯,我们当然需要他们的电子邮件地址(毕竟这是一封电子邮件简报)。 还有什么?

在典型的业务环境中,这通常会引发团队工程师和产品经理之间的对话。在这种情况下,我们既是技术主管,又是产品负责人,因此我们可以发号施令!

从个人经验来看,人们在订阅新闻通讯时通常会使用一次性或屏蔽电子邮件(或者,至少你们大多数人在订阅“从零到生产”时都是这样做的!)。

因此,收集一个名字会很不错,我们可以用它来作为电子邮件问候语(比如臭名昭著的 "Hey,{{subscriber.name}}!" ),也可以在订阅者列表中识别我们认识的人或共同订阅者。

我们不是警察,我们对姓名字段的真实性不感兴趣——我们会让人们在我们的新闻通讯系统中输入他们喜欢的任何身份信息: DenverCoder9, 我们欢迎你。

那么,事情就解决了:我们需要为所有新订阅者提供电子邮件地址和姓名。

鉴于数据是通过 HTML 表单收集的,它将通过 POST 请求的正文传递给我们的后端 API。正文将如何编码?

使用 HTML 表单时,有几种可用的编码方式: application/x-www-form-urlencoded

这最适合我们的用例。

引用 MDN Web 文档,使用 application/x-www-form-urlencoded

在我们的表单中,键和值被编码为键值元组,并以“&”分隔,键和值之间用“=”分隔。键和值中的非字母数字字符均采用百分号编码。

例如:如果名字是 Le Guin, 邮箱是 ursula_le_guin@gmail.com,则 POST 请求体应为 name=le%20guin&email=ursula_le_guin%40gmail.com(空格替换为 %20,而 @ 替换为 %40 - 可在此处找到参考转换表)。

总结:

- 如果使用

application/x-www-form-urlencoded格式提供了有效的姓名和邮箱地址组合,后端应返回 200 OK - 如果姓名或邮箱地址缺失,后端应返回 400 BAD REQUEST。

将我们的需求作为测试

现在我们更好地理解了需要做什么,让我们将我们的期望编码到几个集成测试中。

让我们将新的测试添加到现有的 tests/health_check.rs 文件中——之后我们将重新组织测试套件的文件夹结构。

//! tests/health_check.rs

// [...]

#[tokio::test]

async fn subscribe_returns_a_200_for_valid_form_data() {

// Arrange

let app_address = spawn_app();

let client = reqwest::Client::new();

// Act

let body = "name=le%20guin&email=ursula_le_guin%40gmail.com";

let response = client

.post(&format!("{}/subscriptions", &app_address))

.header("Content-Type", "application/x-www-form-urlencoded")

.body(body)

.send()

.await

.expect("Failed to execute request.");

// Assert

assert_eq!(200, response.status().as_u16());

}

#[tokio::test]

async fn subscribe_returns_a_400_when_data_is_missing() {

// Arrange

let app_address = spawn_app();

let client = reqwest::Client::new();

let test_cases = vec![

("name=le%20guin", "missing the email"),

("email=ursula_le_guin%40gmail.com", "missing the name"),

("", "missing both name and email"),

];

for (invalid_body, error_message) in test_cases {

// Act

let response = client

.post(&format!("{}/subscriptions", &app_address))

.header("Content-Type", "application/x-www-form-urlencoded")

.body(invalid_body)

.send()

.await

.expect("Failed to execute request.");

// Assert

assert_eq!(

400,

response.status().as_u16(),

// Additional customised error message on test failure

"The API did not fail with 400 Bad Request when the payload was {}.",

error_message

);

}

}

subscribe_returns_a_400_when_data_is_missing 是一个表驱动测试的例子,也称为参数化测试。

它在处理错误输入时尤其有用——我们不必多次重复测试逻辑,只需对一组已知无效的主体运行相同的断言即可,这些主体我们预计会以相同的方式失败。

对于参数化测试,在失败时提供清晰的错误消息非常重要:如果您无法确定哪个特定的输入出错,那么在 XYZ 行的断言失败就不太理想!另一方面,该参数化测试涵盖的内容很广泛,因此花更多时间来生成清晰的失败消息是有意义的。

其他语言的测试框架有时原生支持这种测试风格 (例如 pytest 中的参数化测试,或 C# 的 xUnit 中的 InlineData)。Rust 生态系统中有一些 crate,它们扩展了基本测试框架,并提供了类似的功能,但遗憾的是,它们与 #[tokio::test] 宏的互操作性不佳,而我们需要使用宏来编写惯用的异步测试 (参见 rstest 或 test-case)。

现在让我们运行测试套件:

running 3 tests

test subscribe_returns_a_200_for_valid_form_data ... FAILED

test subscribe_returns_a_400_when_data_is_missing ... FAILED

test health_check_works ... ok

failures:

---- subscribe_returns_a_200_for_valid_form_data stdout ----

thread 'subscribe_returns_a_200_for_valid_form_data' panicked at tests/health_check.rs:39:5:

assertion `left == right` failed

left: 200

right: 404

note: run with `RUST_BACKTRACE=1` environment variable to display a backtrace

---- subscribe_returns_a_400_when_data_is_missing stdout ----

thread 'subscribe_returns_a_400_when_data_is_missing' panicked at tests/health_check.rs:63:9:

assertion `left == right` failed: The API did not fail with 400 Bad Request when the payload was missing the email.

left: 400

right: 404

failures:

subscribe_returns_a_200_for_valid_form_data

subscribe_returns_a_400_when_data_is_missing

test result: FAILED. 1 passed; 2 failed; 0 ignored; 0 measured; 0 filtered out; finished in 0.03s

error: test failed, to rerun pass `--test health_check`

正如预期的那样,我们所有的新测试都失败了。

你很快就能发现“自行开发”参数化测试的一个局限性: 一旦一个测试用例失败,执行就会停止,我们也无法知道后续测试用例的结果。

让我们开始实现吧。

从 POST 请求解析表单数据

所有测试都失败了,因为应用程序在 POST 请求到达 /subscriptions 时返回了 404 NOT FOUND 错误。这是合理的:我们没有为该路径注册处理程序。

让我们通过在 src/lib.rs 中添加一个匹配的路由来解决这个问题:

//! src/lib.rs

use std::net::TcpListener;

use actix_web::{App, HttpResponse, HttpServer, Responder, dev::Server, web};

// We were returning `impl Responder` at the very beginning.

// We are now spelling out the type explicitly given that we have

// become more familiar with `actix-web`.

// There is no performance difference! Just a stylistic choice :)

async fn health_check() -> impl Responder {

HttpResponse::Ok()

}

// Let's start simple: we always return a 200 OK

async fn subscribe() -> HttpResponse {

HttpResponse::Ok().finish()

}

pub fn run(listener: TcpListener) -> Result<Server, std::io::Error> {

let server = HttpServer::new(|| {

App::new()

.route("/health_check", web::get().to(health_check))

// A new entry in our routing table for POST /subscriptions requests

.route("/subscriptions", web::post().to(subscribe))

})

.listen(listener)?

.run();

Ok(server)

}

再次运行测试

running 3 tests

test health_check_works ... ok

test subscribe_returns_a_200_for_valid_form_data ... ok

test subscribe_returns_a_400_when_data_is_missing ... FAILED

failures:

---- subscribe_returns_a_400_when_data_is_missing stdout ----

thread 'subscribe_returns_a_400_when_data_is_missing' panicked at tests/health_check.rs:63:9:

assertion `left == right` failed: The API did not fail with 400 Bad Request when the payload was missing the email.

left: 400

right: 200

note: run with `RUST_BACKTRACE=1` environment variable to display a backtrace

failures:

subscribe_returns_a_400_when_data_is_missing

test result: FAILED. 2 passed; 1 failed; 0 ignored; 0 measured; 0 filtered out; finished in 0.03s

subscribe_returns_a_200_for_valid_form_data 现在通过了: 好吧,我们的处理程序将所有传入的数据视为有效数据,这并不奇怪。

subscribe_returns_a_400_when_data_is_missing 仍然是红色 (未通过)。

是时候对该请求主体进行一些真正的解析了。actix-web 为我们提供了什么?

Extractors

actix-web 用户指南中, Extractors 部分尤为突出。 顾名思义,Extractors 用于指示框架从传入请求中提取特定信息。 actix-web 提供了几个开箱即用的提取器,以满足最常见的用例:

- Path 用于从请求路径中获取动态路径段

- Query 用于查询参数

- Json 用于解析 JSON 编码的请求正文

- 等等

幸运的是,有一个Extractor正好可以满足我们的用例: Form

阅读它的文档:

表单数据助手 (

application/x-www-form-urlencoded)。 可用于从请求正文中提取 URL 编码数据,或将 URL 编码数据作为响应发送。

这真是太棒了!

我们该如何使用它?

查看 actix-web 的用户指南:

提取器可以作为处理函数的参数访问。Actix-web 每个处理函数最多支持 10 个提取器。参数位置无关紧要。

例子:

use actix_web::web;

#[derive(serde::Deserialize)]

struct FormData {

username: String,

}

/// Extract form data using serde.

/// This handler get called only if content type is *x-www-form-urlencoded*

/// and content of the request could be deserialized to a `FormData` struct

fn index(form: web::Form<FormData>) -> String {

format!("Welcome {}!", form.username)

}

所以,基本上……你只需将它作为处理程序和 actix-web 的参数添加到那里,当请求到达时,它就会以某种方式为你完成繁重的工作。我们现在先了解一下,稍后再回过头来了解底层发生了什么。

我们的 subscribe handler目前如下所示:

async fn subscribe() -> HttpResponse {

HttpResponse::Ok().finish()

}

使用这个例子作为蓝图,我们可能想要一些类似这样的内容:

//! src/lib.rs

// [...]

#[derive(serde::Deserialize)]

struct FormData {

email: String,

name: String

}

async fn subscribe(_form: web::Form<FormData>) -> HttpResponse {

HttpResponse::Ok().finish()

}

cargo check 并不是很开心

error[E0433]: failed to resolve: use of unresolved module or unlinked crate `serde`

--> src/lib.rs:5:10

|

5 | #[derive(serde::Deserialize)]

| ^^^^^ use of unresolved module or unlinked crate `serde`

好吧,我们需要将 serde 添加到依赖项中。让我们在 Cargo.toml 中添加一行:

[dependencies]

# We need the optional `derive` feature to use `serde`'s procedural macros:

# `#[derive(Serialize)]` and `#[derive(Deserialize)]`.

# The feature is not enabled by default to avoid pulling in

# unnecessary dependencies for projects that do not need it.

serde = { version = "1", features = ["derive"]}

cargo check 现在应该可以通过了, 那 cargo test 呢

running 3 tests

test subscribe_returns_a_200_for_valid_form_data ... ok

test health_check_works ... ok

test subscribe_returns_a_400_when_data_is_missing ... ok

test result: ok. 3 passed; 0 failed; 0 ignored; 0 measured; 0 filtered out; finished in 0.03s

全部通过!

但是为什么?

Form 和 FromRequest

让我们直接进入源码:Form 是什么样子的?

你可以在这里找到它的源代码

这个定义看起来相当简单:

#[derive(PartialEq, Eq, PartialOrd, Ord, Debug)]

pub struct Form<T>(pub T);

它只不过是一个包装器:它对类型 T 进行泛型,然后用于填充 Form 的唯一字段。

这里没什么可看的。

提取魔法在哪里发生?

提取器是实现 FromRequest trait 的类型。

FromRequest 的定义有点杂乱,因为 Rust 尚不支持 trait 定义中的 async fn 。

稍微修改一下,它大致可以归结为这样的东西:

/// Trait implemented by types that can be extracted from request.

///

/// Types that implement this trait can be used with `Route` handlers.

pub trait FromRequest: Sized {

/// The associated error which can be returned.

type Error: Into<Error>;

type Future: Future<Output = Result<Self, Self::Error>>;

fn from_request(req: &HttpRequest, payload: &mut Payload) -> Self::Future;

/// Omitting some ancillary methods that actix-web implements

/// out of the box for you and supporting associated types

/// [...]

}

from_request 将传入的 HTTP 请求的头部(即 HttpRequest)及其有效负载(即 Payload)的字节作为输入。如果提取成功,它将返回 Self;否则,它将返回一个可以转换为 actix_web::Error 的错误类型。

路由处理程序签名中的所有参数都必须实现 FromRequest trait:actix-web 将为每个参数调用 from_request,如果所有参数的提取都成功,它将运行实际的处理程序函数。

如果其中一个提取失败,则相应的错误将返回给调用者,并且处理程序永远不会被调用(actix_web::Error 可以转换为 HttpResponse)。

这非常方便: 您的处理程序无需处理原始的传入请求,而可以直接处理强类型信息,从而大大简化了处理请求所需的代码。

让我们来看看 Form 的 FromRequest 实现:它做了什么?

再次,我稍微修改了实际代码以突出关键元素并忽略具体的实现细节。

impl<T> FromRequest for Form<T>

where

T: DeserializeOwned + 'static,

{

type Error = actix_web::Error;

async fn from_request(

req: &HttpRequest,

payload: &mut Payload

) -> Result<Self, Self::Error> {

// Omitted stuff around extractor configuration (e.g. payload size limits)

match UrlEncoded::new(req, payload).await {

Ok(item) => Ok(Form(item)),

// The error handler can be customised.

// The default one will return a 400, which is what we want.

Err(e) => Err(error_handler(e))

}

}

}

所有繁重的工作似乎都发生在 UrlEncoded struct中。

UrlEncoded 的功能非常丰富: 它透明地处理压缩和未压缩的有效负载,处理请求主体以字节流的形式一次到达一个块的情况,等等。

处理完所有这些事情之后, 关键的部分是:

serde_urlencoded::from_bytes::<T>(&body).map_err(|_| UrlencodedError::Parse)

serde_urlencoded 为 application/x-www-form-urlencoded 数据格式提供(反)序列化支持。

from_bytes 接受一个连续的字节切片作为输入,并根据 URL 编码格式的规则将其反序列化为一个类型 T 的实例:键和值被编码为键值对元组,并以 & 分隔,键和值之间用 = 分隔;键和值中的非字母数字字符均采用百分号编码。

它是如何知道对于泛型类型 T 执行此操作的?

这是因为 T 实现了 serde 的 DeserializedOwned 特性:

impl<T> FromRequest for Form<T>

where

T: DeserializeOwned + 'static,

{

// [...]

}

要了解其内部实际发生的情况,我们需要仔细研究 serde 本身。

下一节关于 serde 的内容涉及一些 Rust 的高级主题。 如果您第一次阅读时没有完全理解,也没关系! 等您熟悉 Rust 之后再回来阅读,并多学习一些 serde,深入了解其中最难的部分。

Rust 中的序列化: serde

为什么我们需要 serde? serde 为我们做了什么?

引用来自它的教程的话:

Serde 是一个用于高效且通用地序列化和反序列化 Rust 数据结构的框架。

一般而言

serde 本身并不支持从/反序列化任何特定数据格式: serde 内部没有处理 JSON、Avro 或 MessagePack 细节的代码。如果您需要支持特定数据格式,则需要引入另一个 crate(例如,用于 JSON 的 serde_json 或用于 Avro 的 avro-rs)。serde 定义了一组接口,或者用它们自己的话说,一个数据模型。

如果您想要实现一个库来支持新数据格式的序列化,则必须提供 Serializer trait 的实现。

Serializer trait 中的每个方法都对应于构成 serde 数据模型的 29 种类型之一——您的 Serializer 实现指定了每种类型如何映射到您的特定数据格式。

例如,如果您要添加对 JSON 序列化的支持,您的 serialize_seq 实现

将输出一个左方括号 [ 并返回一个可用于序列化序列元素的类型。

另一方面,您有 Serialize trait:您为 Rust 类型实现 Serialize::serialize 的目的是指定如何根据 serde 的数据模型,使用 Serializer trait 中提供的方法对其进行分解。

再次使用序列示例,以下是 Rust 中为 Vec 实现 Serialize 的方式:

use serde::ser::{Serialize, Serializer, SerializeSeq};

impl<T> Serialize for Vec<T>

where

T: Serialize,

{

fn serialize<S>(&self, serializer: S) -> Result<S::Ok, S::Error>

where

S: Serializer,

{

let mut seq = serializer.serialize_seq(Some(self.len()))?;

for element in self {

seq.serialize_element(element)?;

}

seq.end()

}

}

这使得 serde 对数据格式保持不可知:一旦你的类型实现了 Serialize, 你就可以自由地使用任何具体的 Serializer 实现来实际执行序列化步骤 - 也就是说,你可以将你的类型序列化为 crates.io 上可用的 Serializer 实现的任何格式(剧透:几乎所有常用的数据格式)。

反序列化也是如此,通过 Deserialize 和 Deserializer 进行,并在生命周期方面有一些额外的细节,以支持零拷贝反序列化。

效率

serde 的速度变慢是否是因为其对底层数据格式具有泛型性?

不是,这要归功于一个称为单态化的过程。

每次使用一组具体类型调用泛型函数时,Rust 编译器都会创建函数体的副本,将泛型类型参数替换为具体类型。这使得编译器能够针对所涉及的具体类型优化函数体的每个实例:其结果与我们不使用泛型或特征,为每种类型编写单独的函数所获得的结果并无二致。换句话说,我们不会因为使用泛型而付出任何运行时成本。

这个概念非常强大,通常被称为零成本抽象:使用高级语言结构可以生成与使用更丑陋/更“手工编写”的实现相同的机器码。因此,我们可以编写更易于人类阅读的代码(正如它所期望的那样!),而无需在最终成品的质量上做出妥协。

Serde 在内存使用方面也非常谨慎:我们之前提到的中间数据模型是通过 trait 方法隐式定义的,并没有真正的中间序列化结构体。

如果您想了解更多信息,Josh Mcguigan 写了一篇精彩的深度文章,题为《理解 Serde》。

还值得指出的是,对特定类型进行(反)序列化所需的所有信息在编译时即可获得,没有任何运行时开销。

其他语言中的(反)序列化器通常利用运行时反射来获取要(反)序列化的类型的信息(例如,它们的字段名称列表)。Rust 不提供运行时反射, 因此所有信息都必须预先指定。

便捷

这就是 #[derive(Serialize)] 和 #[derive(Deserialize)] 发挥作用的地方。

你肯定不想手动详细说明项目中定义的每个类型应该如何执行序列化。这很繁琐,容易出错,而且会浪费你本应专注于特定于应用程序的逻辑的时间。

这两个过程宏与 derive feature flag 后面的 serde 捆绑在一起,将解析类型的定义并自动为你生成正确的 Serialize/Deserialize 实现。

把所有东西放在一起

结合目前所学的知识,让我们再看一下我们的订阅处理程序:

#[derive(serde::Deserialize)]

struct FormData {

email: String,

name: String,

}

async fn subscribe(_form: web::Form<FormData>) -> HttpResponse {

HttpResponse::Ok().finish()

}

现在,我们对正在发生的事情有了清晰的了解:

- 在调用 subscribe 之前,actix-web 会为所有 subscribe 的输入参数调用 from_request 方法: 在我们的例子中,是 Form::from_request;

- Form::from_request 会尝试根据 URL 编码规则,利用 serde_urlencoded 和 FormData 的 Deserialize 实现(由

#[derive(serde::Deserialize)]自动生成),将 body 反序列化为 FormData - 如果 Form::from_request 失败,则会向调用者返回 400 BAD REQUEST 错误码。如果成功,则会调用 subscribe 并返回 200 OK 错误码。

稍作思考,您会惊叹不已:它看起来如此简单,但其中却蕴含着如此丰富的内容 ——我们主要依靠 Rust 的强大功能以及其生态系统中一些最完善的 crate。

存储数据: 数据库

我们的 POST /订阅端点通过了测试,但其实用性相当有限:我们没有在任何地方存储有效的电子邮件和姓名。

我们从 HTML 表单收集的信息没有永久记录。

该如何解决这个问题?

在定义云原生时,我们列出了我们期望在系统中看到的一些新兴行为: 特别是,我们希望在易出错的环境中运行时实现高可用性。

因此,我们的应用程序被迫分布式——应该在多台机器上运行多个实例,以应对硬件故障。

这会对数据持久性产生影响:我们不能依赖主机的文件系统作为传入数据的存储层。

我们保存在磁盘上的任何内容都只能供应用程序的众多副本之一使用。

此外,如果宿主机崩溃,这些数据很可能会消失。

这解释了为什么云原生应用程序通常是无状态的: 它们的持久性需求被委托给专门的外部系统——数据库。

选择一个数据库

我们的newsletter项目应该使用什么数据库?

我先给出我的个人经验法则,听起来可能有点争议:

如果您不确定持久性需求,请使用关系数据库。

如果您不需要大规模部署,请使用 PostgreSQL。

在过去的二十年里,数据库产品种类繁多。

从数据模型的角度来看, NoSQL 运动为我们带来了文档存储 (例如 MongoDB) 、键值存储 (例如 AWS DynamoDB)、图形数据库(例如 Neo4J) 等。

我们有一些数据库使用 RAM 作为主存储(例如 Redis)。

我们有一些数据库通过列式存储针对分析查询进行了优化(例如 AWS RedShift)。

系统设计中存在着无限可能,您绝对应该充分利用这些可能性。

然而,如果您对应用程序所使用的数据访问模式还不甚了解,那么使用专门的数据存储解决方案很容易让您陷入困境。

关系数据库可以说是万能的:在构建应用程序的第一个版本时,它们通常是一个不错的选择,可以在您探索领域约束的过程中为您提供支持。

即使是关系数据库,也有很多选择。

除了 PostgreSQL 和 MySQL 等经典数据库外,您还会发现一些令人兴奋的新数据库,例如 AWS Aurora、Google Spanner 和 CockroachDB。

它们有什么共同点?

它们都是为了扩展而构建的。远远超出了传统 SQL 数据库的处理能力。

如果您担心扩展性问题,请务必考虑一下。如果不是,则无需考虑额外的复杂性。

这就是我们最终选择 PostgreSQL 的原因:它是一项久经考验的技术,如果您需要托管服务,它受到所有云提供商的广泛支持,开源,拥有详尽的文档,易于在本地运行以及通过 Docker 在 CI 中运行,并且在 Rust 生态系统中得到良好支持。

选择一个数据库 Crate

截至 2020 年 8 月,在 Rust 项目中与 PostgreSQL 交互时,有三个最常用的选项:

译者注: 在2025还有一个比较欢迎的选项叫做 sea-ql, 基于sqlx 的一个数据库crate

这三个项目都非常受欢迎,并且被广泛采用,在生产环境中也占有相当的份额。您该如何选择呢? 这取决于您对以下三个主题的看法:

- 编译时安全性

- SQL 优先 vs. DSL 用于查询构建

- 异步 vs. 同步接口

编译期安全

与关系数据库交互时,很容易犯错——例如,我们可能会:

- 查询中提到的列名或表名出现拼写错误;

- 尝试执行数据库引擎拒绝的操作(例如,将字符串和数字相加,或在错误的列上连接两个表);

- 期望返回的数据中包含实际上不存在的某个字段。

关键问题是:我们何时意识到自己犯了错误?

在大多数编程语言中,错误发生在运行时: 当我们尝试执行查询时,

数据库会拒绝它,然后我们会收到错误或异常。使用 tokio-postgres 时就会发生这种情况。

diesel 和 sqlx 试图通过在编译时检测大多数此类错误来加快反馈周期。

diesel 利用其 CLI 将数据库schema生成为 Rust 代码的表示,然后用于检查所有查询的假设。

相反, sqlx 使用过程宏在编译时连接到数据库,并检查提供的查询是否确实合理

查询接口

tokio-postgres 和 sqlx 都要求您直接使用 SQL 编写查询。

而 diesel 则提供了自己的查询构建器:查询以 Rust 类型表示,您可以通过调用其方法来添加过滤器、执行连接和类似的操作。这通常被称为领域特定语言 (DSL)。

哪一个更好?

一如既往,这取决于具体情况。

SQL 具有极高的可移植性——您可以在任何需要与关系数据库交互的项目中使用它, 无论应用程序使用哪种编程语言或框架编写。

而 diesel 的 DSL 仅在使用 diesel 时才有意义:您需要预先支付学习成本才能熟练掌握它,而且只有在您当前和未来的项目中坚持使用 diesel 时,这才值得。还值得指出的是,使用 diesel 的 DSL 表达复杂查询可能很困难, 您最终可能还是需要编写原始 SQL。

另一方面,Diesel 的 DSL 使得编写可重用组件变得更加容易:你可以将复杂的查询拆分成更小的单元,并在多个地方使用它们,就像使用普通的 Rust 函数一样。

异步支持

我记得在某处读过一篇关于异步IO的精彩解释, 大致如下:

线程用于并行工作,异步用于并行等待。

您的数据库并不与您的应用程序位于同一物理主机上:要运行查询,您必须执行网络调用。

异步数据库驱动程序不会减少处理单个查询所需的时间,但它可以让您的应用程序在等待数据库返回结果的同时,充分利用所有 CPU 核心来执行其他有意义的工作(例如,处理另一个 HTTP 请求)。

这是否足以让您接受异步代码带来的额外复杂性?

这取决于您应用程序的性能要求。

一般来说,对于大多数用例来说,在单独的线程池上运行查询应该已经足够了。同时,如果您的 Web 框架已经是异步的,那么使用异步数据库驱动程序实际上会减少您的麻烦28。

sqlx 和 tokio-postgres 都提供了异步接口,而 diesel 是同步的,并且 不打算在不久的将来推出异步支持。

还值得一提的是,tokio-postgres 是目前唯一支持查询流水线的 crate。该功能在 sqlx 中仍处于设计阶段,而我在 diesel 的文档或问题跟踪器中找不到任何提及。

总结

让我们总结一下比较矩阵中涵盖的所有内容:

| Crate | 编译期安全 | 查询接口 | 异步 |

|---|---|---|---|

| tokio-postgres | No | SQL | Yes |

| sqlx | Yes | SQL | Yes |

| diesel | Yes | DSL | No |

我们的选择: sqlx

对于“从零到生产”阶段,我们将使用 sqlx:它的异步支持简化了与 actix-web 的集成,而无需我们在编译时保证上做出妥协。

由于它使用原始 SQL 进行查询,因此它还限制了我们必须覆盖和精通的 API 范围。

有副作用的集成测试

我们想要实现什么目标?

让我们再回顾一下“满意案例”测试:

#[tokio::test]

async fn subscribe_returns_a_200_for_valid_form_data() {

// Arrange

let app_address = spawn_app();

let client = reqwest::Client::new();

// Act

let body = "name=le%20guin&email=ursula_le_guin%40gmail.com";

let response = client

.post(&format!("{}/subscriptions", &app_address))

.header("Content-Type", "application/x-www-form-urlencoded")

.body(body)

.send()

.await

.expect("Failed to execute request.");

// Assert

assert_eq!(200, response.status().as_u16());

}

我们现有的断言是不够的。

我们无法仅通过查看 API 响应来判断预期的业务结果是否已实现——我们想知道是否发生了副作用,例如数据存储。

我们想检查新订阅者的详细信息是否已实际保存。

该怎么做呢?

我们有两个选择:

- 利用公共 API 的另一个端点来检查应用程序状态;

- 在测试用例中直接查询数据库。

如果可能,您应该选择选项 1:您的测试不会考虑 API 的实现细节(例如底层数据库技术及其模式),因此不太可能受到未来重构的干扰。

遗憾的是,我们的 API 上没有任何公共端点可以让我们验证订阅者是否存在。

我们可以添加一个 GET /subscriptions 端点来获取现有订阅者列表,但这样一来,我们就必须担心它的安全性:我们不希望在没有任何形式的身份验证的情况下,将订阅者的姓名和电子邮件暴露在公共互联网上。

我们最终可能会编写一个 GET /subscriptions 端点(也就是说,我们不想登录生产数据库来查看订阅者列表),但我们不应该仅仅为了测试正在开发的功能而开始编写新功能。

让我们咬紧牙关,在测试中编写一个小查询。当出现更好的测试策略时,我们会将其删除。

设置数据库

为了在测试套件中运行查询,我们需要:

- 一个正在运行的 Postgres 实例

- 一个用于存储订阅者数据的表

Docker

我们将使用 Docker 来运行 Postgres。在启动测试套件之前,我们将使用 Postgres 的官方 Docker 镜像启动一个新的 Docker 容器。

您可以按照 Docker 网站上的说明将其安装到您的机器上。

让我们为它创建一个小型 Bash 脚本 scripts/init_db.sh,并添加一些自定义 Postgres 默认设置的功能:

#!/usr/bin/env bash

set -x

set -eo pipefail

# Check if a custom user has been set, otherwise default to 'postgres'

DB_USER=${POSTGRES_USER:=postgres}

# Check if a custom password has been set, otherwise default to 'password'

DB_PASSWORD="${POSTGRES_PASSWORD:=password}"

# Check if a custom database name has been set, otherwise default to 'newsletter'

DB_NAME="${POSTGRES_DB:=newsletter}"

# Check if a custom port has been set, otherwise default to '5432'

DB_PORT="${POSTGRES_PORT:=5432}"

# Launch postgres using Docker

docker run \

-e POSTGRES_USER=${DB_USER} \

-e POSTGRES_PASSWORD=${DB_PASSWORD} \

-e POSTGRES_DB=${DB_NAME} \

-p "${DB_PORT}":5432 \

-d postgres \

postgres -N 1000

# ^ Increased maximum number of connections for testing purposes

执行如下命令让这个文件可以被执行

chmod +x scripts/init_db.sh

然后我们可以启动 PostgreSQL

./scripts/init_db.sh

如果你运行 docker ps 你应该会看到类似这样的内容

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

06b8e8a7252d postgres "docker-entrypoint.s…" 5 seconds ago Up 4 seconds 0.0.0.0:5432->5432/tcp, [::]:5432->5432/tcp zen_herschel

注意 - 如果您没有在用 Linux,端口映射位可能会略有不同!

数据库迁移

为了存储订阅者的详细信息,我们需要创建第一张表。

要向数据库添加新表,我们需要更改其架构——这通常称为数据库迁移。

sqlx-cli

sqlx 提供了一个命令行界面 sqlx-cli 来管理数据库迁移。

我们可以使用以下命令安装 CLI:

cargo install --version=0.8.6 sqlx-cli --no-default-features --features postgres

运行 sqlx --help 检查一切是否按预期工作。

数据库创建

我们通常要运行的第一个命令是 sqlx database create。根据帮助文档:

Creates the database specified in your DATABASE_URL

Usage: sqlx database create [OPTIONS]

Options:

--no-dotenv Do not automatically load `.env` files

-D, --database-url <DATABASE_URL> Location of the DB, by default will be read from the DATABASE_URL env var or `.env`

files [env: DATABASE_URL=]

--connect-timeout <CONNECT_TIMEOUT> The maximum time, in seconds, to try connecting to the database server before

returning an error [default: 10]

-h, --help Print help

在我们的例子中,这并非绝对必要:我们的 Postgres Docker 实例已经自带了一个名为 newsletter 的默认数据库,这要归功于我们在启动它时使用环境变量指定的设置。尽管如此,您仍需要在 CI 管道和生产环境中执行创建步骤,所以无论如何都值得介绍一下。

正如帮助文档所示,sqlx database create 依赖于 DATABASE_URL 环境变量来

确定要执行的操作。

DATABASE_URL 应为有效的 Postgres 连接字符串 - 格式如下:

postgres://${DB_USER}:${DB_PASSWORD}@${DB_HOST}:${DB_PORT}/${DB_NAME}

因此,我们可以在 scripts/init_db.sh 脚本中添加几行

# [...]

export DATABASE_URL=postgres://${DB_USER}:${DB_PASSWORD}@localhost:${DB_PORT}/${DB_NAME}

sqlx database create

您可能偶尔会遇到一个恼人的问题:当我们尝试运行 sqlx database create 命令时,Postgres 容器尚未准备好接受连接。

我经常遇到这种情况,因此想找个解决办法:我们需要等待 Postgres 恢复正常, 然后才能开始对其运行命令。让我们将脚本更新为:

#!/usr/bin/env bash

set -x

set -eo pipefail

# Check if a custom user has been set, otherwise default to 'postgres'

DB_USER=${POSTGRES_USER:=postgres}

# Check if a custom password has been set, otherwise default to 'password'

DB_PASSWORD="${POSTGRES_PASSWORD:=password}"

# Check if a custom database name has been set, otherwise default to 'newsletter'

DB_NAME="${POSTGRES_DB:=newsletter}"

# Check if a custom port has been set, otherwise default to '5432'

DB_PORT="${POSTGRES_PORT:=5432}"

# Launch postgres using Docker

docker run \

-e POSTGRES_USER=${DB_USER} \

-e POSTGRES_PASSWORD=${DB_PASSWORD} \

-e POSTGRES_DB=${DB_NAME} \

-p "${DB_PORT}":5432 \

-d postgres \

postgres -N 1000

# ^ Increased maximum number of connections for testing purposes

# Keep pinging Postgres until it's ready to accept commands

export PGPASSWORD="${DB_PASSWORD}"

until psql -h "localhost" -U "${DB_USER}" -p "${DB_PORT}" -d "postgres" -c '\q'; do

>&2 echo "Postgres is still unavailable - sleeping"

sleep 1

done

>&2 echo "Postgres is up and running on port ${DB_PORT}!"

export DATABASE_URL=postgres://${DB_USER}:${DB_PASSWORD}@localhost:${DB_PORT}/${DB_NAME}

sqlx database create

问题解决了!

健康检查使用 Postgres 的命令行客户端 psql。请查看以下说明,了解如何在您的操作系统上安装它。

脚本本身没有附带清单文件来声明其依赖项:很遗憾,在没有安装所有先决条件的情况下启动脚本的情况非常常见。这通常会导致脚本在执行过程中崩溃,有时会导致系统处于半崩溃状态。

我们可以在初始化脚本中做得更好:让我们在一开始就检查 psql 和 sqlx-cli 是否都已安装。

set -x

set -eo pipefail

if ! [ -x "$(command -v psql)" ]; then

echo >&2 "Error: psql is not installed."

exit 1

fi

if ! [ -x "$(command -v sqlx)" ]; then

echo >&2 "Error: sqlx is not installed."

echo >&2 "Use:"

echo >&2 "

cargo install --version=0.5.7 sqlx-cli --no-default-features --features postgres"

echo >&2 "to install it."

exit 1

fi

# [...]

添加迁移

现在让我们创建第一个迁移

# Assuming you used the default parameters to launch Postgres in Docker!

export DATABASE_URL=postgres://postgres:password@127.0.0.1:5432/newsletter

sqlx migrate add create_subscriptions_table

您的项目中现在应该会出现一个新的顶级目录 - migrations。sqlx 的 CLI 将把我们项目的所有迁移文件存储在这里。

在 migrations 下,您应该已经有一个名为 {timestamp}_create_subscriptions_table.sql 的文件。

我们需要在这里编写第一个迁移文件的 SQL 代码。

让我们快速勾勒出我们需要的查询:

-- migrations/{timestamp}_create_subscriptions_table.sql

-- Create Subscriptions Table

CREATE TABLE subscriptions(

id uuid NOT NULL,

PRIMARY KEY (id),

email TEXT NOT NULL UNIQUE,

name TEXT NOT NULL,

subscribed_at timestamptz NOT NULL

);

关于主键的争论一直存在:有些人喜欢使用具有业务含义的列(例如,电子邮件、自然键),而另一些人则觉得使用没有任何业务含义的合成键更安全(例如,ID、随机生成的 UUID、代理键)。

除非有非常充分的理由,否则我通常默认使用合成标识符——如果您对此有不同意见,请随意。

另外需要注意以下几点:

- 我们使用 subscribed_at 来跟踪订阅的创建时间(timestamptz 是一种支持时区的日期和时间类型)

- 我们使用 UNIQUE 约束在数据库级别强制确保电子邮件的唯一性

- 我们强制所有字段的每一列都应使用 NOT NULL 约束进行填充

- 我们使用 TEXT 格式来表示电子邮件和姓名,因为我们对它们的最大长度没有任何限制

数据库约束是防止应用程序错误的最后一道防线,但它是有代价的——数据库必须确保所有检查都通过后才能将新数据写入表。因此,约束会影响我们的写入吞吐量,即单位时间内我们可以在表中插入/更新的行数。

特别是 UNIQUE 约束,它会在我们的电子邮件列上引入一个额外的 BTree 索引:该索引必须在每次执行 INSERT/UPDATE/DELETE 查询时更新,而且会占用磁盘空间。

就我们的具体情况而言,我不会太担心: 我们的邮件列表必须非常受欢迎,才会遇到写入吞吐量的问题。如果真的遇到这个问题,那绝对是个好事。

运行迁移

我们可以使用以下方法对数据库进行迁移:

sqlx migrate run

它的行为与 sqlx database create 相同——它会查看 DATABASE_URL 环境变量,以了解需要迁移的数据库。

让我们将它添加到 scripts/init_db.sh 脚本中:

#!/usr/bin/env bash

set -x

set -eo pipefail

if ! [ -x "$(command -v psql)" ]; then

echo >&2 "Error: psql is not installed."

exit 1

fi

if ! [ -x "$(command -v sqlx)" ]; then

echo >&2 "Error: sqlx is not installed."

echo >&2 "Use:"

echo >&2 "

cargo install --version=0.5.7 sqlx-cli --no-default-features --features postgres"

echo >&2 "to install it."

exit 1

fi

# Check if a custom user has been set, otherwise default to 'postgres'

DB_USER=${POSTGRES_USER:=postgres}

# Check if a custom password has been set, otherwise default to 'password'

DB_PASSWORD="${POSTGRES_PASSWORD:=password}"

# Check if a custom database name has been set, otherwise default to 'newsletter'

DB_NAME="${POSTGRES_DB:=newsletter}"

# Check if a custom port has been set, otherwise default to '5432'

DB_PORT="${POSTGRES_PORT:=5432}"

if [[ -z "${SKIP_DOCKER}" ]]

then

# Launuh postgrecs sing Docker

docker run \

-e POSTGRES_USER=${DB_USER} \

-e POSTGRES_PASSWORD=${DB_PASSWORD} \

-e POSTGRES_DB=${DB_NAME} \

-p "${DB_PORT}":5432 \

-d postgres \

postgres -N 1000

# ^ Increased maximum number of connections for testing purposes

fi

# Keep pinging Postgres until it's ready to accept commands

export PGPASSWORD="${DB_PASSWORD}"

until psql -h "localhost" -U "${DB_USER}" -p "${DB_PORT}" -d "postgres" -c '\q'; do

>&2 echo "Postgres is still unavailable - sleeping"

sleep 1

done

>&2 echo "Postgres is up and running on port ${DB_PORT}!"

export DATABASE_URL=postgres://${DB_USER}:${DB_PASSWORD}@localhost:${DB_PORT}/${DB_NAME}

sqlx database create

sqlx migrate run

注意在这里我们进行了两处修改, 一处是文件末尾的 sqlx migrate run 另外一处是对 SKIP_DOCKER 环境变量的判断

我们将 docker run 命令置于 SKIP_DOCKER 标志之后,以便轻松针对现有 Postgres 实例运行迁移,而无需手动将其关闭并使用 scripts/init_db.sh 重新创建。如果我们的脚本未启动 Postgres,此命令在 CI 中也非常有用。

现在,我们可以使用以下命令迁移数据库

SKIP_DOCKER=true ./scripts/init_db.sh

您应该能够在输出中发现类似这样的内容

+ sqlx migrate run

如果您使用您最喜欢的 Postgres GUI 检查数据库,您现在会看到一个 subscriptions 表,旁边还有一个全新的 _sqlx_migrations 表: 这是 sqlx 跟踪针对您的数据库运行了哪些迁移的地方——现在它应该包含一行,用于记录我们的 create_subscriptions_table 迁移。

编写我们的第一个查询

我们已迁移并运行数据库。该如何与它通信?

Sqlx Feature Flags

我们安装了 sqlx-cli,但实际上还没有将 sqlx 本身添加为我们应用程序的依赖项。

我们在 Cargo.toml 中添加一行新代码:

[dependencies.sqlx]

version = "0.8.6"

default-features = false

features = [

"tls-rustls",

"macros",

"postgres",

"uuid",

"chrono",

"migrate",

"runtime-tokio"

]

是的,有很多功能开关。让我们逐一介绍一下:

tls-rustls指示 sqlx 使用 actix 运行时作为其 Future,并使用 rustls 作为 TLS 后端;macros允许我们访问 sqlx::query! 和 sqlx::query_as!,我们将会广泛使用它们;postgres解锁 Postgres 特有的功能(例如非标准 SQL 类型);uuid增加了将 SQL UUID 映射到 uuid crate 中的 Uuid 类型的支持。我们需要它来处理我们的 id 列;chrono增加了将 SQL timestamptz 映射到 chrono cratev 中的DateTime<T>类型的支持。我们需要它来处理我们的 subscribed_at 列;migrate允许我们访问 sqlx-cli 后台用来管理迁移的相同函数。事实证明,它对我们的测试套件很有用。 这些应该足够我们完成本章所需的工作了。

配置管理

连接到 Postgres 数据库最简单的入口点是 PgConnection。

PgConnection 实现了 Connection trait,它为我们提供了一个 connect 方法:

它接受连接字符串作为输入,并异步返回一个 Result<PostgresConnection,sqlx::Error> 。

我们从哪里获取连接字符串?

我们可以在应用程序中硬编码一个连接字符串,然后将其用于测试。

或者,我们可以选择立即引入一些基本的配置管理机制。

这比听起来简单,而且可以节省我们在整个应用程序中追踪一堆硬编码值的成本。

config crate 是 Rust 配置方面的“瑞士军刀”:它支持多种文件格式,并允许您分层组合不同的源(例如环境变量、配置文件等),从而轻松地根据每个部署环境定制应用程序的行为。

我们暂时不需要任何花哨的东西: 一个配置文件就可以了。

腾出空间

目前,我们所有的应用程序代码都位于一个文件 lib.rs 中。

为了避免在添加新功能时造成混乱,我们需要快速将其拆分成多个子模块。我们希望采用以下文件夹结构:

src/

├── configuration.rs

├── lib.rs

├── main.rs

├── routes

│ ├── health_check.rs

│ └── subscriptions.rs

├── routes.rs

└── startup.rs

lib.rs 看起来是这样

//! src/lib.rs

pub mod configuration;

pub mod routes;

pub mod startup;

startup.rs 将包含我们的运行函数, health_check 函数存放在 routes/health_check.rs 中, subscribe 和 FormData 函数存放在 routes/subscriptions.rs 中,

configuration.rs 初始为空。这两个处理程序都重新导出到 routes.rs 中:

//! /src/routes.rs

mod health_check;

mod subscriptions;

pub use health_check::*;

pub use subscriptions::*;

您可能需要添加一些 pub 可见性修饰符, 以及对 main.rs 和 tests/health_check.rs 中的 use 语句进行一些修正。

请确保 cargo test 通过, 然后再继续下一步。

读取配置文件

要使用 config 管理配置,我们必须将应用程序设置表示为实现 serde 的 Deserialize trait 的 Rust 类型。

让我们创建一个新的 Settings struct:

//! src/configuration.rs

#[derive(serde::Deserialize)]

pub struct Settings {}

目前我们有两组配置值:

- 应用程序端口,actix-web 监听传入请求(目前在 main.rs 中硬编码为 8000)

- 数据库连接参数

让我们在“设置”中为每个配置值添加一个字段:

#[derive(serde::Deserialize)]

pub struct Settings {

pub database: DatabaseSettings,

pub application_port: u16

}

#[derive(serde::Deserialize)]

pub struct DatabaseSettings {

pub username: String,

pub password: String,

pub port: u16,

pub host: String,

pub database_name: String,

}

我们需要在 DatabaseSettings 之上添加 #[derive(serde::Deserialize)], 否则编译器会报错

error[E0277]: the trait bound `DatabaseSettings: configuration::_::_serde::Deserialize<'_>` is not satisfied

--> src/configuration.rs:3:19

|

3 | pub database: DatabaseSettings,

| ^^^^^^^^^^^^^^^^ the trait `configuration::_::_serde::Deserialize<'_>` is not implemented for `DatabaseSettings`

|

这是有道理的: 为了使整个类型可反序列化,类型中的所有字段都必须可反序列化。

我们有配置类型了,接下来做什么?

首先, 让我们使用以下命令将配置添加到依赖项中

cargo add config

我们想从名为 configuration 的配置文件中读取我们的应用程序设置:

pub fn get_configuration() -> Result<Settings, config::ConfigError> {

let settings = config::Config::builder()

// Add configuration values from a file named `configuration`.

// It will look for any top-level file with an extension

// that `config` knows how to parse: yaml, json, etc.

.add_source(config::File::with_name("configuration"))

.build()

.unwrap();

// Try to convert the configuration values it read into

// our Settings type

settings.try_deserialize()

}

让我们修改 main 方法 以读取配置作为第一步:

//! src/main.rs

use std::net::TcpListener;

use zero2prod::{configuration::get_configuration, run};

#[tokio::main]

async fn main() -> std::io::Result<()> {

let configuration = get_configuration().expect("Failed to read config");

let address = format!("0.0.0.0:{}", configuration.application_port);

let listener = TcpListener::bind(address)?;

run(listener)?.await

}

如果这时候尝试运行 cargo run 会崩溃

thread 'main' panicked at src/configuration.rs:20:10:

called `Result::unwrap()` on an `Err` value: configuration file "configuration" not found

note: run with `RUST_BACKTRACE=1` environment variable to display a backtrace

让我们写一个配置文件来修复这个问题

我们可以使用任何文件格式,只要 config crate 知道如何处理它: 我们将选择 YAML。

# configuration.yaml

application_port: 8000

database:

host: "127.0.0.1"

port: 5432

username: "postgres"

password: "password"

database_name: "newsletter"

cargo run 现在应该可以顺利执行了。

连接到 Postgres

PgConnection::connect 需要单个连接字符串作为输入, 而 DatabaseSettings 则提供了对所有连接参数的精细访问。

让我们添加一个便捷的 connection_string 方法来做到这一点:

//! src/configuration.rs

// [...]

impl DatabaseSettings {

pub fn connection_string(&self) -> String {

format!(

"postgres://{}:{}@{}:{}/{}",

self.username, self.password, self.host, self.port, self.database_name

)

}

}

我们终于可以连接了!

让我们调整一下正常情况下的测试:

use sqlx::{Connection, PgConnection};

use zero2prod::configuration::get_configuration;

#[tokio::test]

async fn subscribe_returns_a_200_for_valid_form_data() {

// Arrange

let app_address = spawn_app();

let configuration = get_configuration().expect("Failed to read configuration");

let connection_string = configuration.database.connection_string();

// The `Connection` trait MUST be in scope for us to invoke

// `PgConnection::connect` - it is not an inherent method of the struct!

let connection = PgConnection::connect(&connection_string)

.await

.expect("Failed to connect to Postgres.");

let client = reqwest::Client::new();

// Act

let body = "name=le%20guin&email=ursula_le_guin%40gmail.com";

let response = client

.post(&format!("{}/subscriptions", &app_address))

.header("Content-Type", "application/x-www-form-urlencoded")

.body(body)

.send()

.await

.expect("Failed to execute request.");

// Assert

assert_eq!(200, response.status().as_u16());

}

而且... cargo test 通过了!

我们刚刚确认, 测试结果显示我们能够成功连接到 Postgres!

对于世界来说,这是一小步,而对于我们来说,却是一大步。

我们的测试断言

现在我们已经连接上了,终于可以编写测试断言了。

我们之前 10 页一直梦想着这些断言。

我们将使用 sqlx 的 query! 宏:

#[tokio::test]

async fn subscribe_returns_a_200_for_valid_form_data() {

// [...]

// The connection has to be marked as mutable!

let mut connection = PgConnection::connect(&connection_string)

.await

.expect("Failed to connect to Postgres.");

// [...]

// Assert

assert_eq!(200, response.status().as_u16());

let saved = sqlx::query!("SELECT email, name FROM subscriptions",)

.fetch_one(&mut connection)

.await

.expect("Failed to fetch saved subscription.");

assert_eq!(saved.email, "ursula_le_guin@gmail.com");

assert_eq!(saved.name, "le guin");

}

saved 的类型是什么? query! 宏返回一个匿名记录类型: 在编译时验证查询有效后,会生成一个结构体定义,其结果中的每个列都有一个成员 (例如, email 列对应的是 saved.email)。

如果我们尝试运行 cargo test, 将会报错:

error: set `DATABASE_URL` to use query macros online, or run `cargo sqlx prepare` to update the query cache

--> tests/health_check.rs:52:17

|

52 | let saved = sqlx::query!("SELECT email, name FROM subscriptions",)

| ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

|

= note: this error originates in the macro `$crate::sqlx_macros::expand_query` which comes from the expansion of the macro `sqlx::query` (in Nightly builds, run with -Z macro-backtrace for more inf

o)

error: could not compile `zero2prod` (test "health_check") due to 1 previous error

正如我们之前讨论过的,sqlx 在编译时会联系 Postgres 来检查查询是否格式正确。就像 sqlx-cli 命令一样,它依赖 DATABASE_URL 环境变量来获取数据库的地址。

我们可以手动导出 DATABASE_URL, 但每次启动机器并开始处理这个项目时,都会遇到同样的问题。我们不妨参考 sqlx 作者的建议——添加一个顶层 .env 文件。

DATABASE_URL="postgres://postgres:password@localhost:5432/newsletter"

sqlx 会从中读取 DATABASE_URL, 省去了我们每次都重新导出环境变量的麻烦。

数据库连接参数放在两个地方 (.env 和

configuration.yaml) 感觉有点麻烦,但这不是什么大问题: configuration.yaml 可以用来

在应用程序编译后更改其运行时行为,而 .env 只与我们的开发流程、构建和测试步骤相关。

将 .env 文件提交到版本控制——我们很快就会在持续集成 (CI) 中用到它!

让我们再次尝试运行 cargo test:

running 3 tests

test health_check_works ... ok

test subscribe_returns_a_400_when_data_is_missing ... ok

test subscribe_returns_a_200_for_valid_form_data ... FAILED

failures:

---- subscribe_returns_a_200_for_valid_form_data stdout ----

thread 'subscribe_returns_a_200_for_valid_form_data' panicked at tests/health_check.rs:55:10:

Failed to fetch saved subscription.: RowNotFound

它失败了,这正是我们想要的!

现在我们可以专注于修补应用程序,让它恢复正常。

更新 CI 流

如果你检查一下,你会发现你的 CI 流现在无法执行我们在开始时引入的大多数检查。

我们的测试现在依赖于正在运行的 Postgres 数据库才能正确执行。由于 sqlx 的编译时检查,我们所有的构建命令 (cargo check、cargo lint、cargo build )都需要一个正常运行的数据库!

我们不想再冒险使用一个损坏的 CI。

您可以在这里找到 GitHub Actions 设置的更新版本。只需更新 general.yml 文件即可。

持久化新订阅者

就像我们在测试中编写了 SELECT 查询来检查哪些订阅已持久保存到数据库中一样,现在我们需要编写 INSERT 查询,以便在收到有效的 POST /subscriptions 请求时实际存储新订阅者的详细信息。

让我们看看我们的handler:

use actix_web::{HttpResponse, web};

#[derive(serde::Deserialize)]

pub struct FormData {

email: String,

name: String,

}

pub async fn subscribe(_form: web::Form<FormData>) -> HttpResponse {

HttpResponse::Ok().finish()

}

要在 subscribe 中执行查询,我们需要获取数据库connection。

让我们来看看如何获取。

actix-web 中的应用程序状态

到目前为止,我们的应用程序完全是无状态的:我们的处理程序仅处理来自传入请求的数据。

actix-web 让我们能够将与单个传入请求的生命周期无关的其他数据附加到应用程序 - 即所谓的应用程序状态。

您可以使用 App 上的 app_data 方法向应用程序状态添加信息。

让我们尝试使用 app_data 将 PgConnection 注册为应用程序状态的一部分。我们需要修改 run 方法,使其与 TcpListener 一起接受 PgConnection:

//! src/startup.rs

use std::net::TcpListener;

use actix_web::{dev::Server, web, App, HttpServer};

use sqlx::PgConnection;

use crate::routes::{health_check, subscribe};

pub fn run(

listener: TcpListener,

// New parameter!

connection: PgConnection,

) -> Result<Server, std::io::Error> {

let server = HttpServer::new(|| {

App::new()

.route("/health_check", web::get().to(health_check))

.route("/subscriptions", web::post().to(subscribe))

.app_data(connection)

})